Ritmo de aprendizaje e impulso

Introducción al aprendizaje profundo con PyTorch

Jasmin Ludolf

Senior Data Science Content Developer, DataCamp

Actualizar pesos con SGD

- Entrenar una red neuronal = resolver un problema de optimización.

Optimizador de descenso de gradiente estocástico (SGD)

sgd = optim.SGD(model.parameters(), lr=0.01, momentum=0.95)

- Dos argumentos:

- tasa de aprendizaje: controla el tamaño del paso

- impulso: añade inercia para evitar quedarse atascado

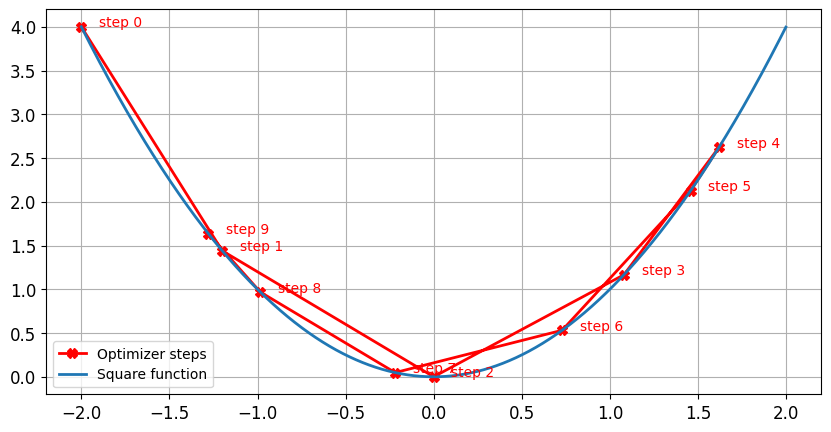

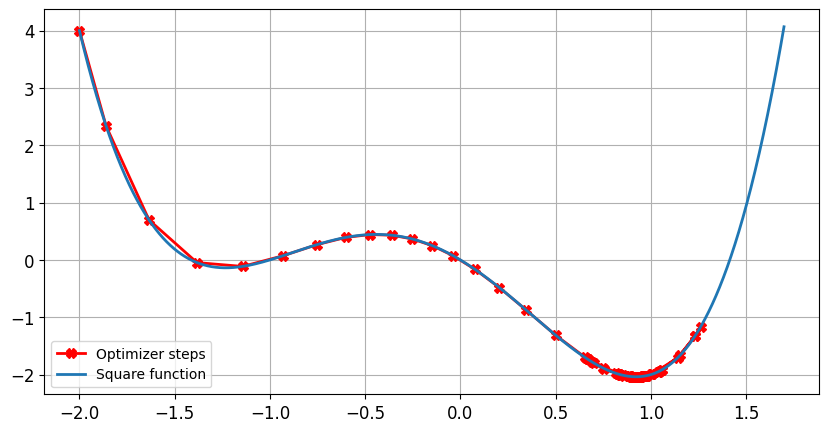

Impacto de la tasa de aprendizaje: ritmo de aprendizaje óptimo

- El tamaño del paso disminuye casi a cero a medida que el gradiente se hace más pequeño

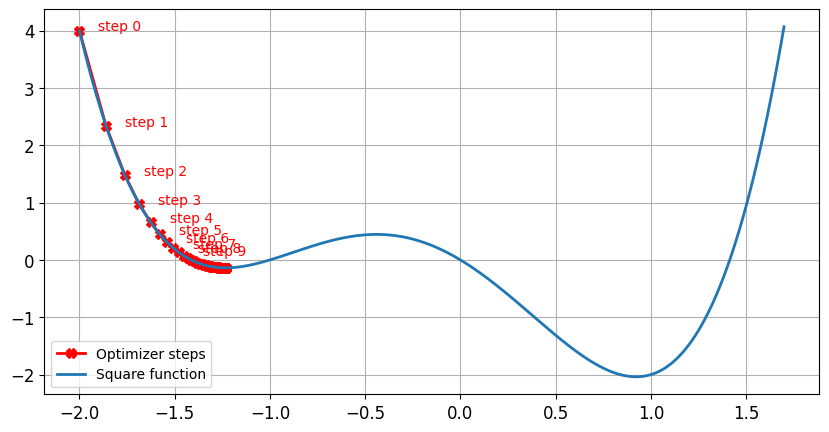

Impacto de la tasa de aprendizaje: ritmo de aprendizaje insuficiente

Impacto de la tasa de aprendizaje: elevado ritmo de aprendizaje

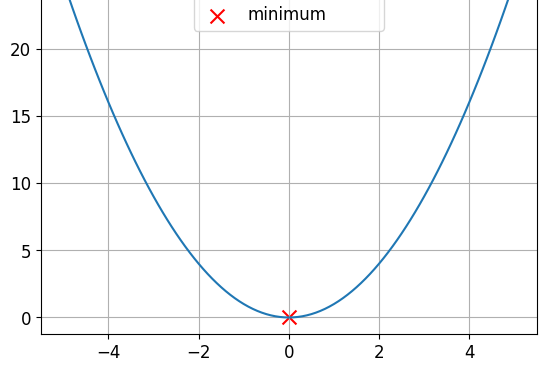

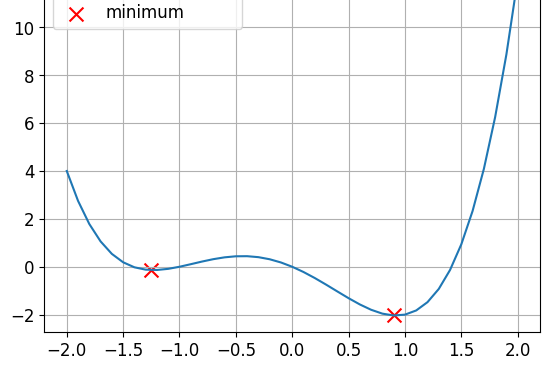

Funciones convexas y no convexas

Se trata de una función convexa.

Se trata de una función no convexa.

- Las funciones de pérdida no son convexas

Sin impulso

lr = 0.01momentum = 0después de 100 pasos se ha encontrado el mínimo parax = -1.23yy = -0.14

Con impulso

lr = 0.01momentum = 0.9después de 100 pasos se ha encontrado el mínimo parax = 0.92yy = -2.04

Resumen

$$

| Tasa de aprendizaje | Impulso |

|---|---|

| Controla el tamaño del paso | Controla la inercia |

| Demasiado alto → bajo rendimiento | Ayuda a escapar del mínimo local |

| Demasiado bajo → entrenamiento lento | Demasiado pequeño → el optimizador se atasca |

| Rango típico: 0.01 ($10^{-2}$) and 0.0001 ($10^{-4}$) | Rango típico: 0,85 a 0,99 |

¡Vamos a practicar!

Introducción al aprendizaje profundo con PyTorch