Funções de ativação ReLU

Introdução ao Aprendizado Profundo com o PyTorch

Jasmin Ludolf

Senior Data Science Content Developer, DataCamp

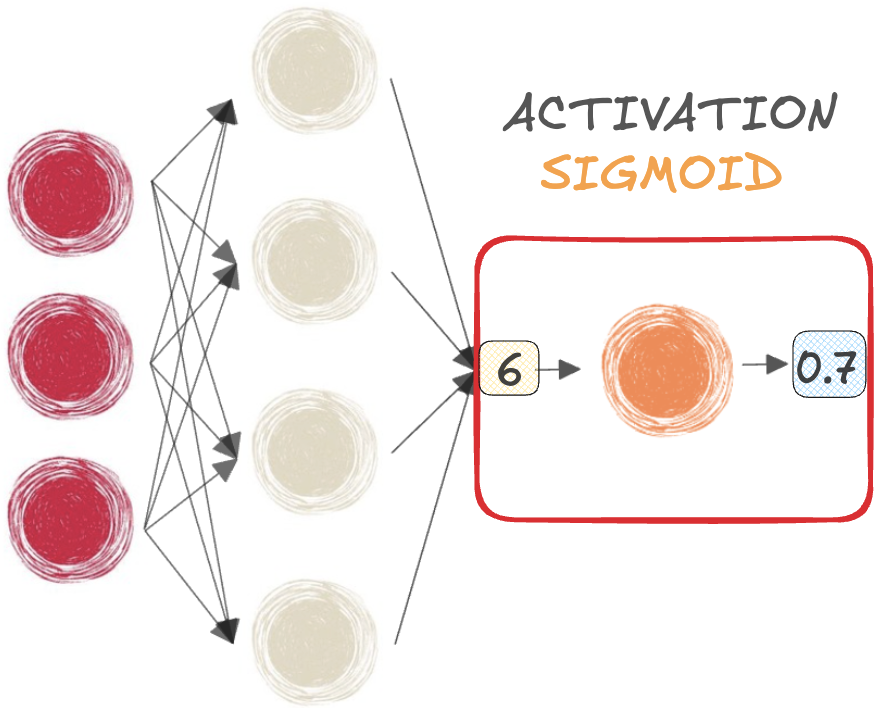

Funções sigmoide e softmax

$$

- SIGMOIDE para classificação BINÁRIA

$$

- SOFTMAX para classificação MULTICLASSE

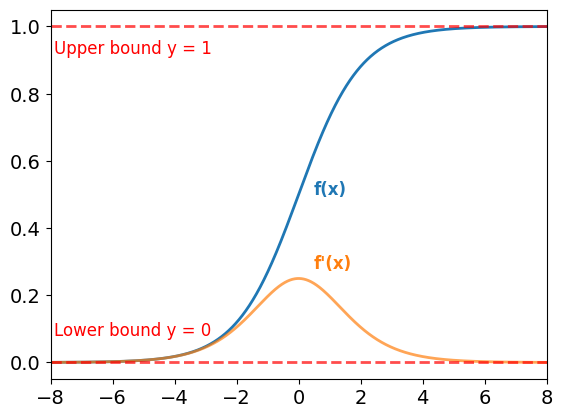

Limitações das funções sigmoide e softmax

Função sigmoide:

- Saídas limitadas entre 0 e 1

- Usável em qualquer lugar na rede

Gradientes:

- Muito pequeno para valores grandes e pequenos de x

- Causa saturação e leva ao problema dos gradientes desaparecendo

$$

A função softmax também sofre com a saturação

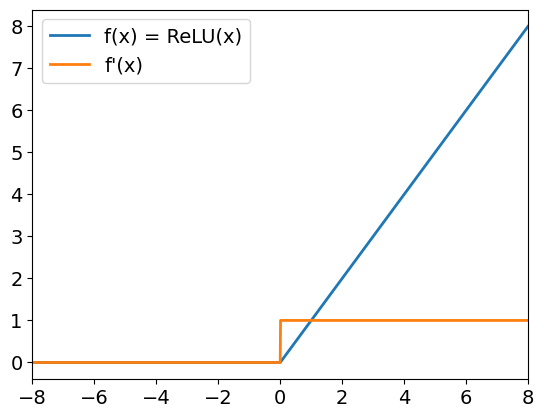

ReLU

Rectified Linear Unit (ReLU):

f(x) = max(x, 0)- Entradas positivas: saída é igual entrada

- Entradas negativas: saída é 0

- Ajuda a superar os gradientes desaparecendo

$$

No PyTorch:

relu = nn.ReLU()

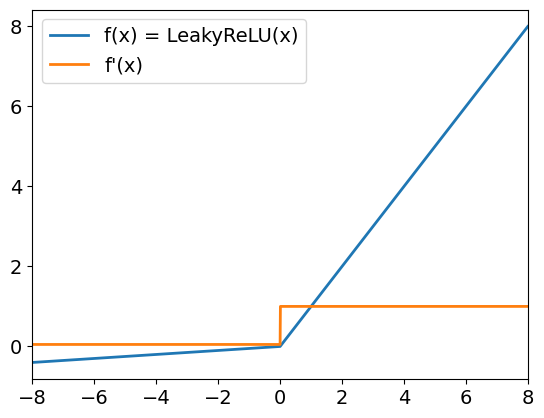

Leaky ReLu

Leaky ReLu:

- Entradas positivas se comportam como ReLU

- Entradas negativas dimensionadas por um pequeno coeficiente (padrão 0.01)

- Gradientes para entradas negativas não são zero

$$

No PyTorch:

leaky_relu = nn.LeakyReLU(

negative_slope = 0.05)

Vamos praticar!

Introdução ao Aprendizado Profundo com o PyTorch