Lernrate und Momentum

Einführung in Deep Learning mit PyTorch

Jasmin Ludolf

Senior Data Science Content Developer, DataCamp

Gewichte mit SGD aktualisieren

- Ein neuronales Netz zu trainieren bedeutet, ein Optimierungsproblem zu lösen.

Optimierer für den Stochastic Gradient Descent (SGD)

sgd = optim.SGD(model.parameters(), lr=0.01, momentum=0.95)

- Zwei Argumente:

- Lernrate: steuert die Schrittgröße

- Momentum: fügt Trägheit hinzu, um ein Steckenbleiben zu vermeiden

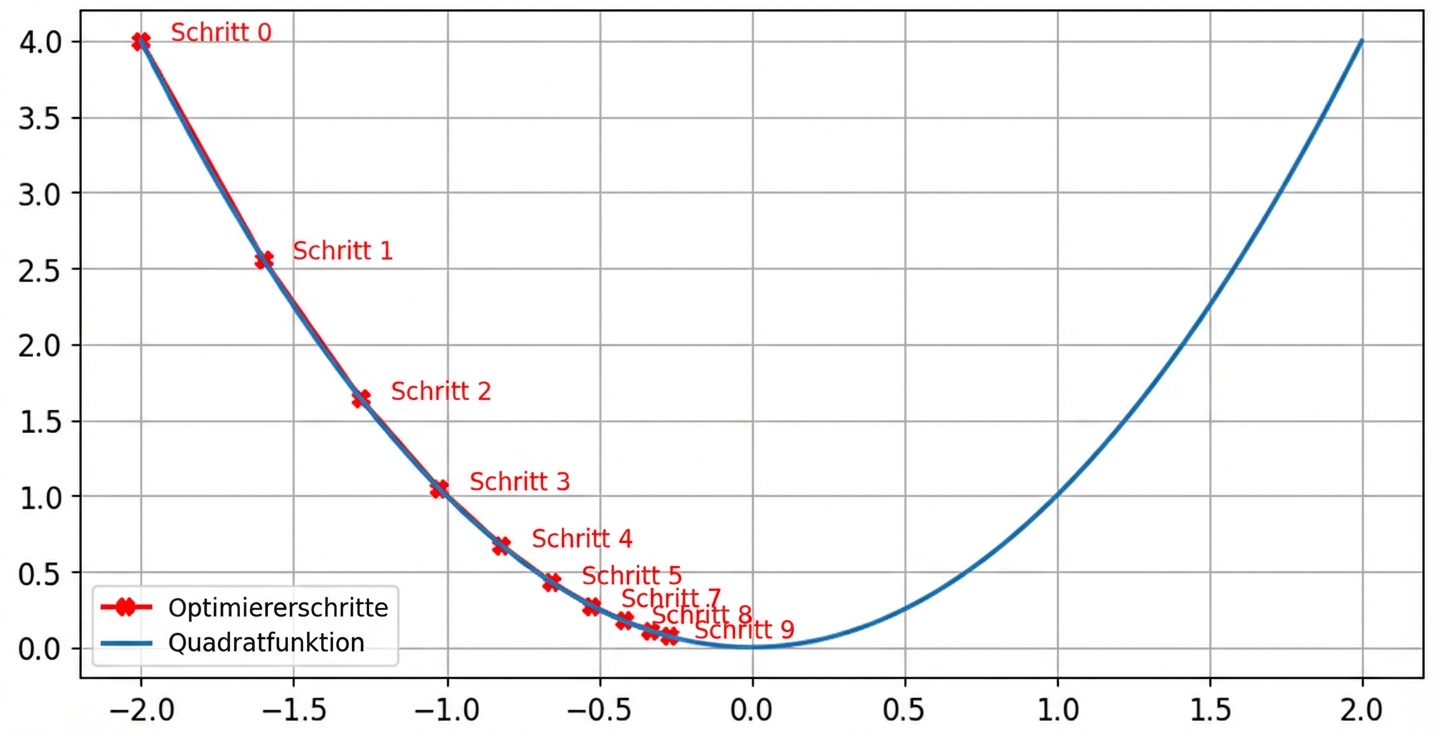

Auswirkungen der Lernrate: optimale Lernrate

- Die Schrittweite sinkt gegen Null, wenn der Gradient kleiner wird

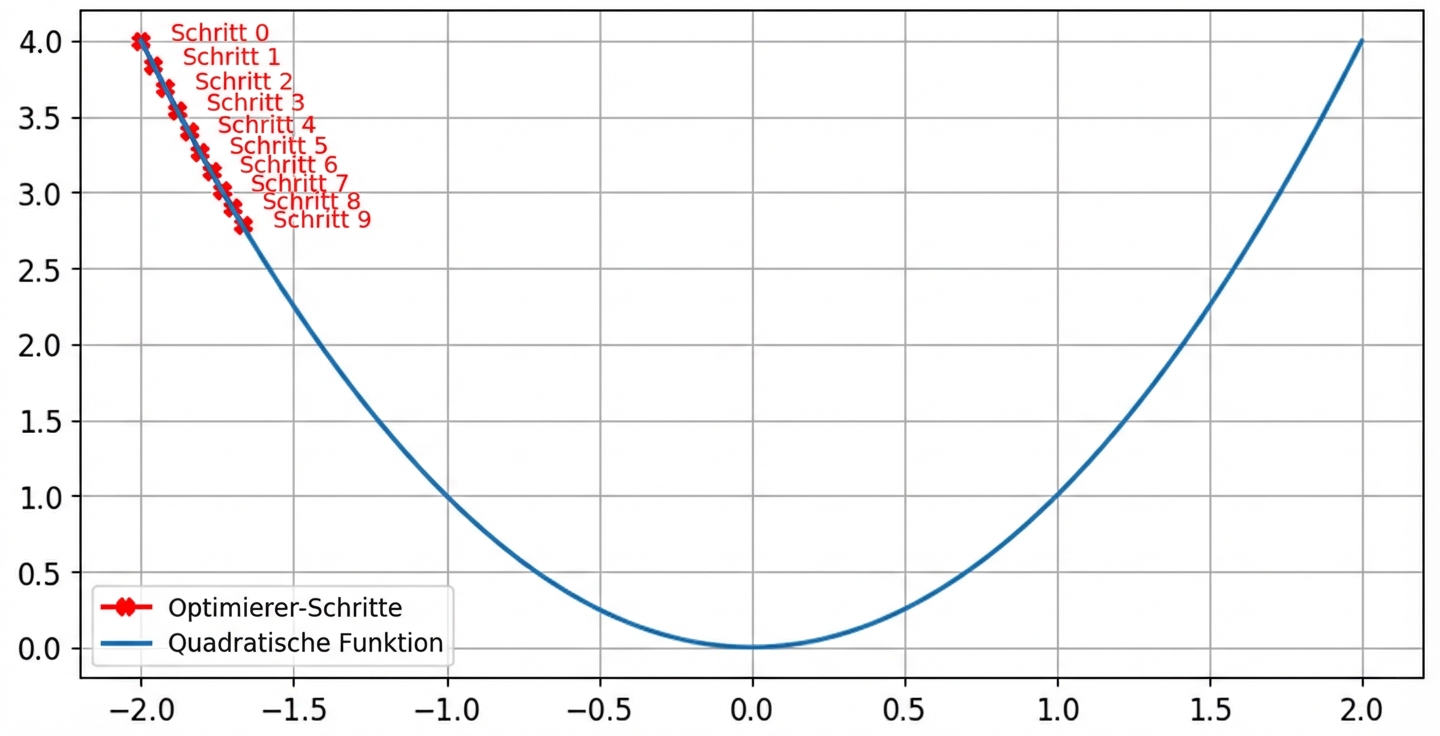

Auswirkungen der Lernrate: kleine Lernrate

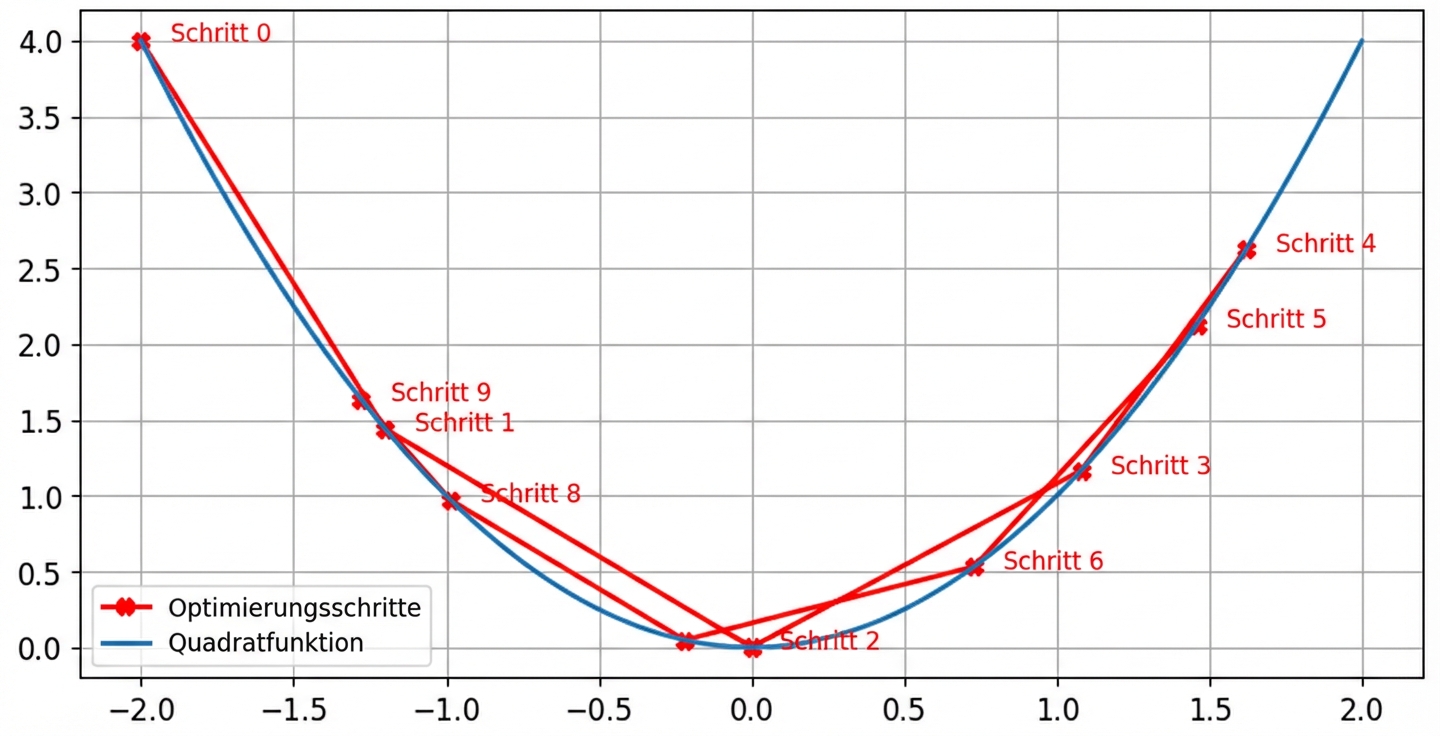

Auswirkungen der Lernrate: hohe Lernrate

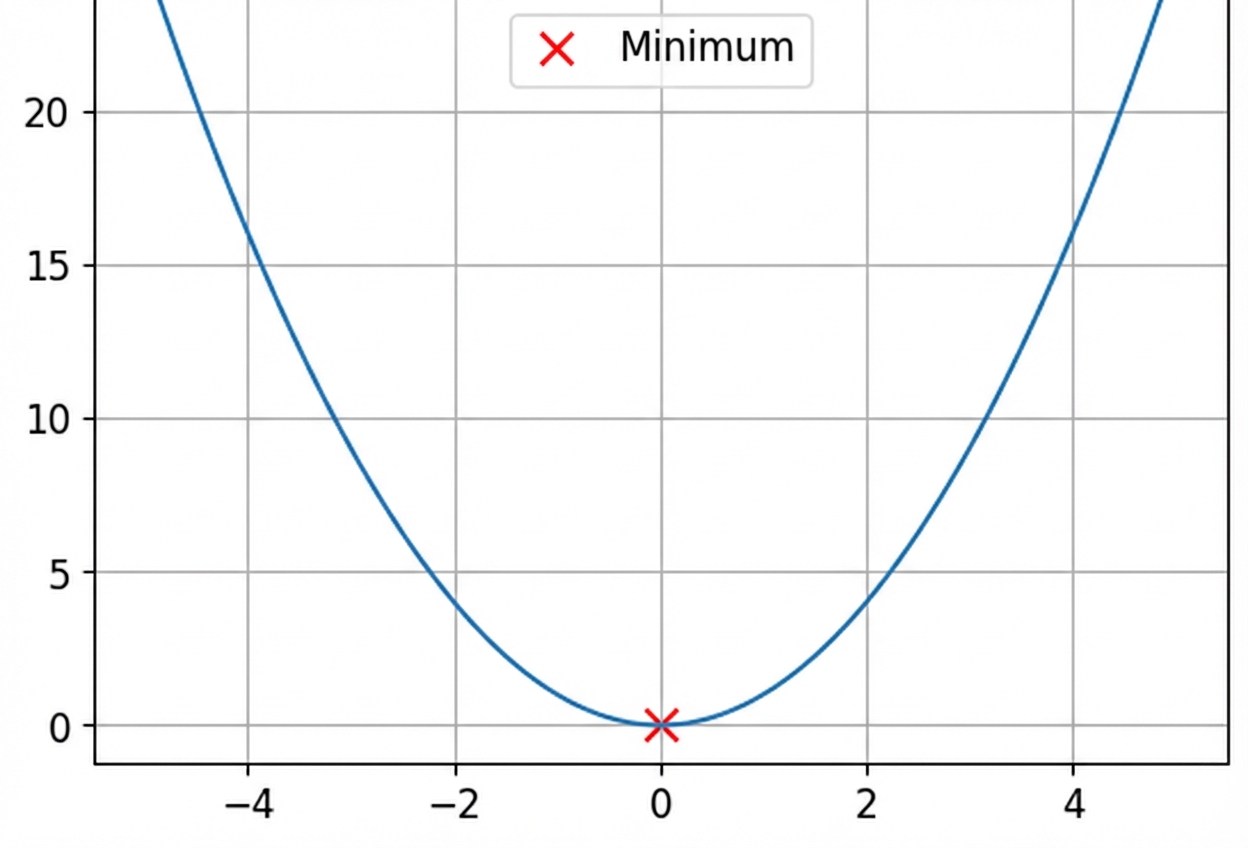

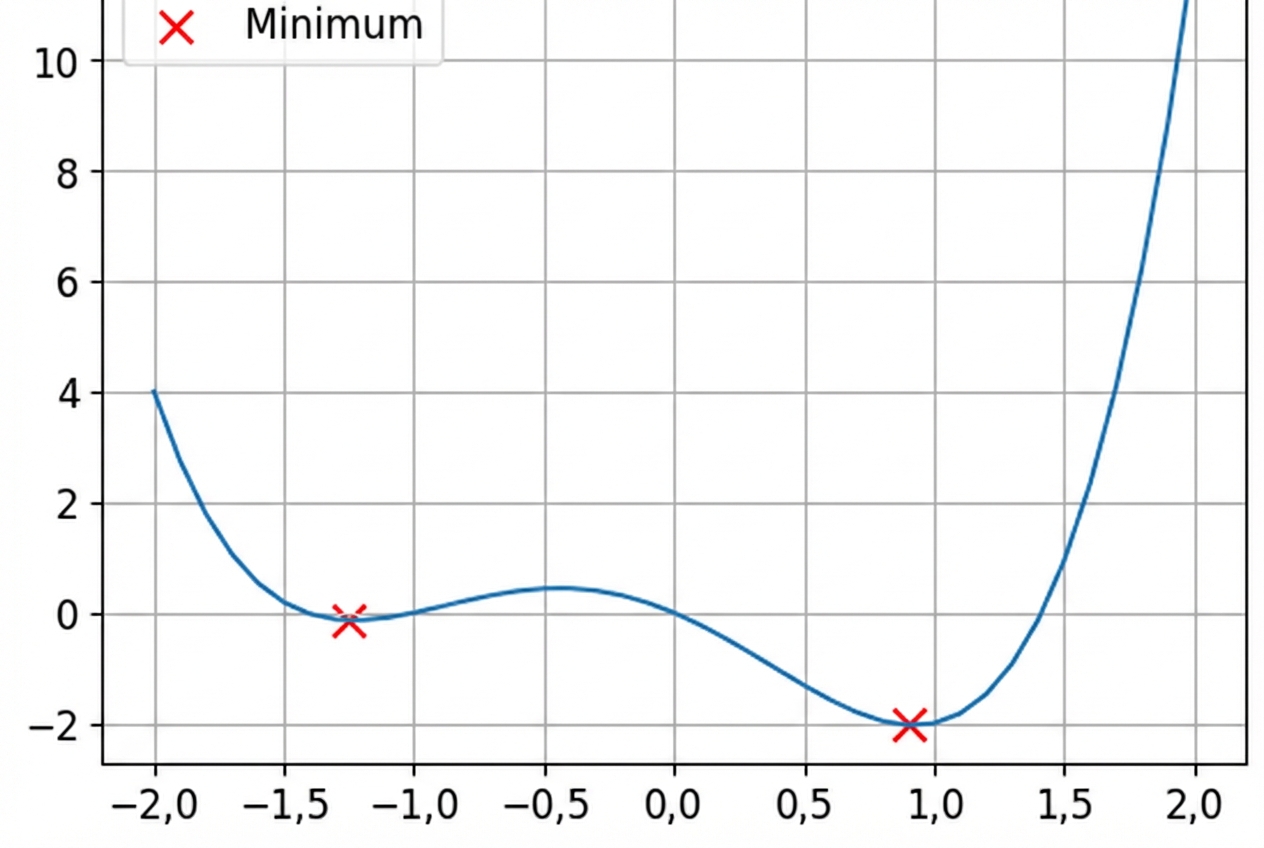

Konvexe und nicht-konvexe Funktionen

Dies ist eine konvexe Funktion.

Dies ist eine nicht-konvexe Funktion.

- Verlustfunktionen sind nicht konvex

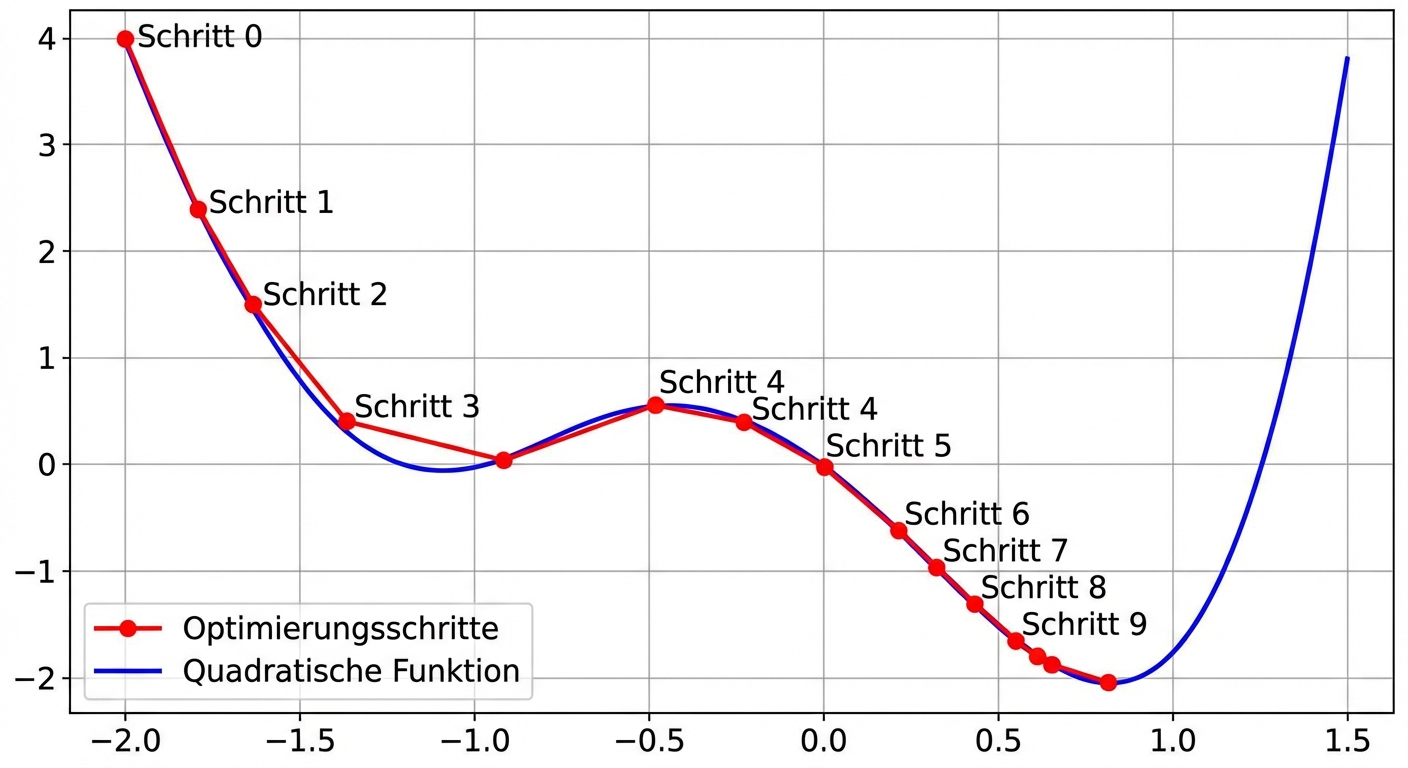

Ohne Momentum

lr = 0.01momentum = 0nach 100 Schritten das Minimum gefunden fürx = -1.23undy = -0.14

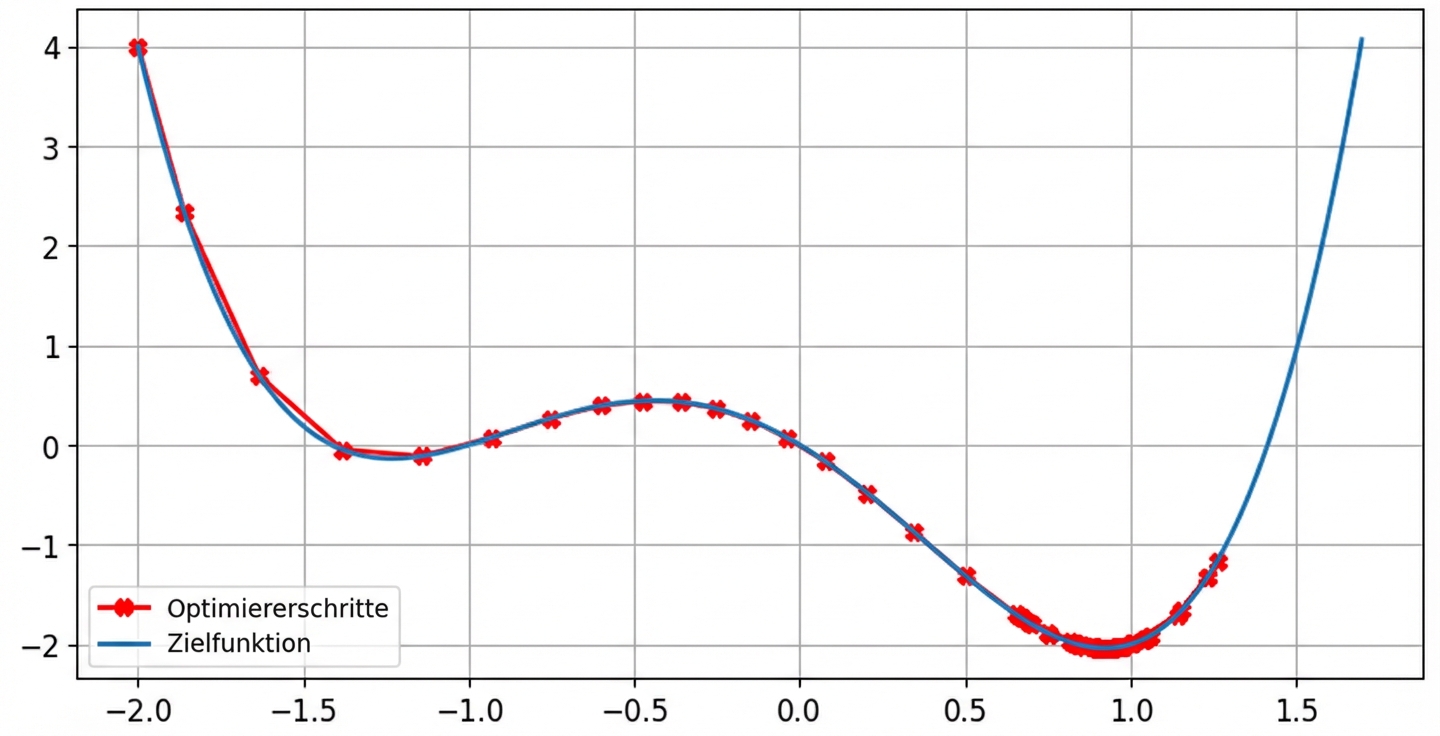

Mit Momentum

lr = 0.01momentum = 0.9nach 100 Schritten das Minimum gefunden fürx = 0.92undy = -2.04

Zusammenfassung

$$

| Lernrate | Momentum |

|---|---|

| Steuert die Schrittgröße | Steuert die Trägheit |

| Zu hoch → schlechte Leistung | Hilft, dem lokalen Minimum zu entgehen |

| Zu niedrig → langsames Training | Zu klein → Optimierer bleibt stecken |

| Typischer Bereich: 0,01 ($10^{-2}$) und 0,0001 ($10^{-4}$) | Typischer Bereich: 0,85 bis 0,99 |

Lass uns üben!

Einführung in Deep Learning mit PyTorch