Fine-tuning

Konzepte großer Sprachmodelle (LLMs)

Vidhi Chugh

AI strategist and ethicist

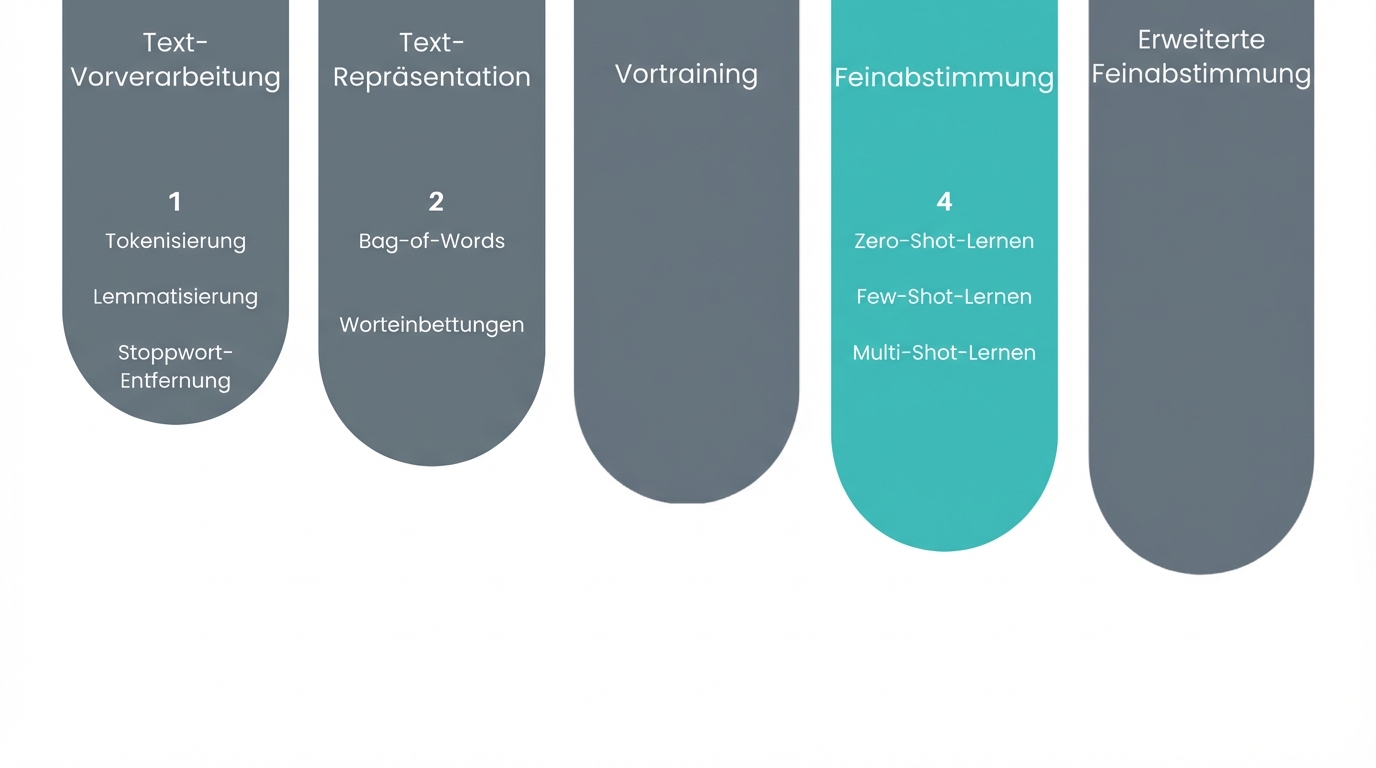

In welchem Abschnitt befinden wir uns?

- Pre-Training

School education

- Fine-tuning

University specialization

1 Freepik

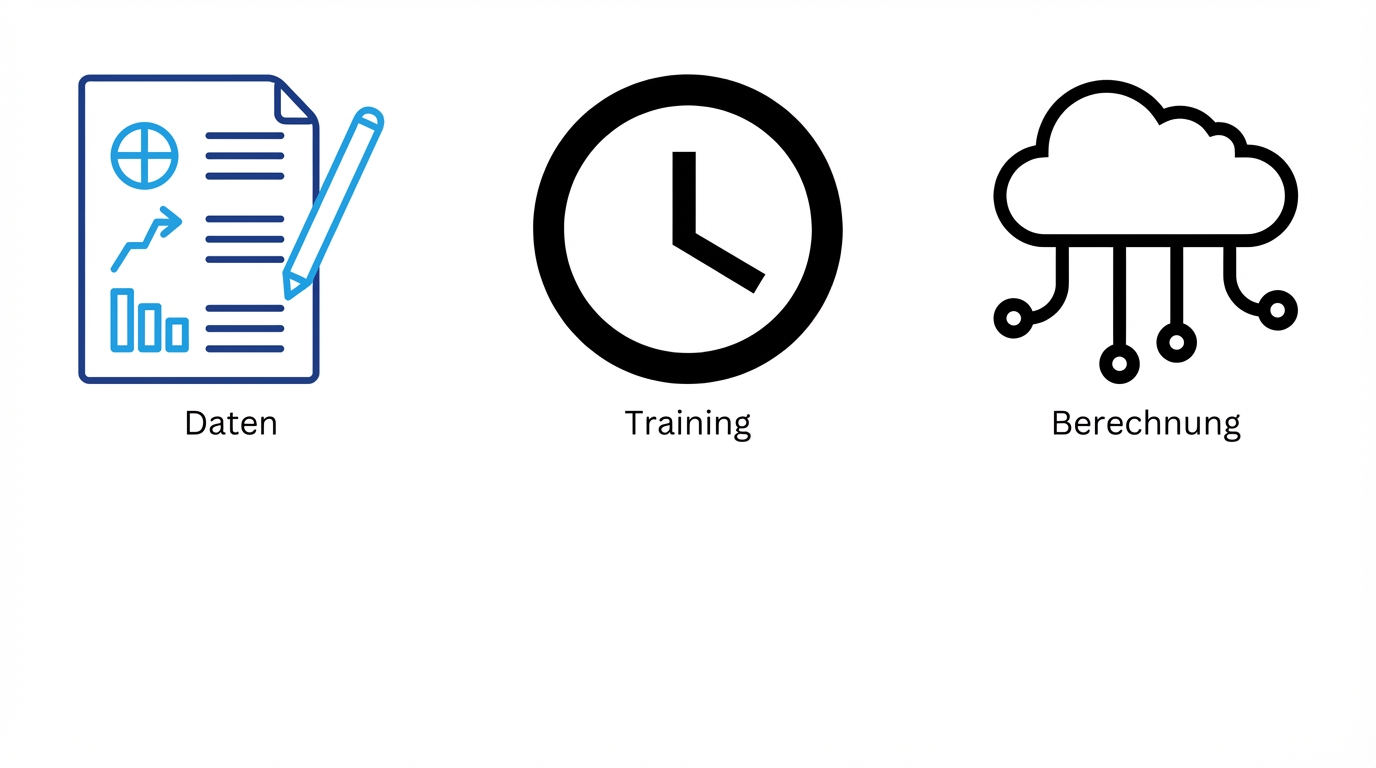

„Größe“ ist eine Herausforderung

- Fine-Tuning kann helfen

- Leistungsstarke Computer

- Effiziente Methoden zum Trainieren von Modellen

- Viele Trainingsdaten

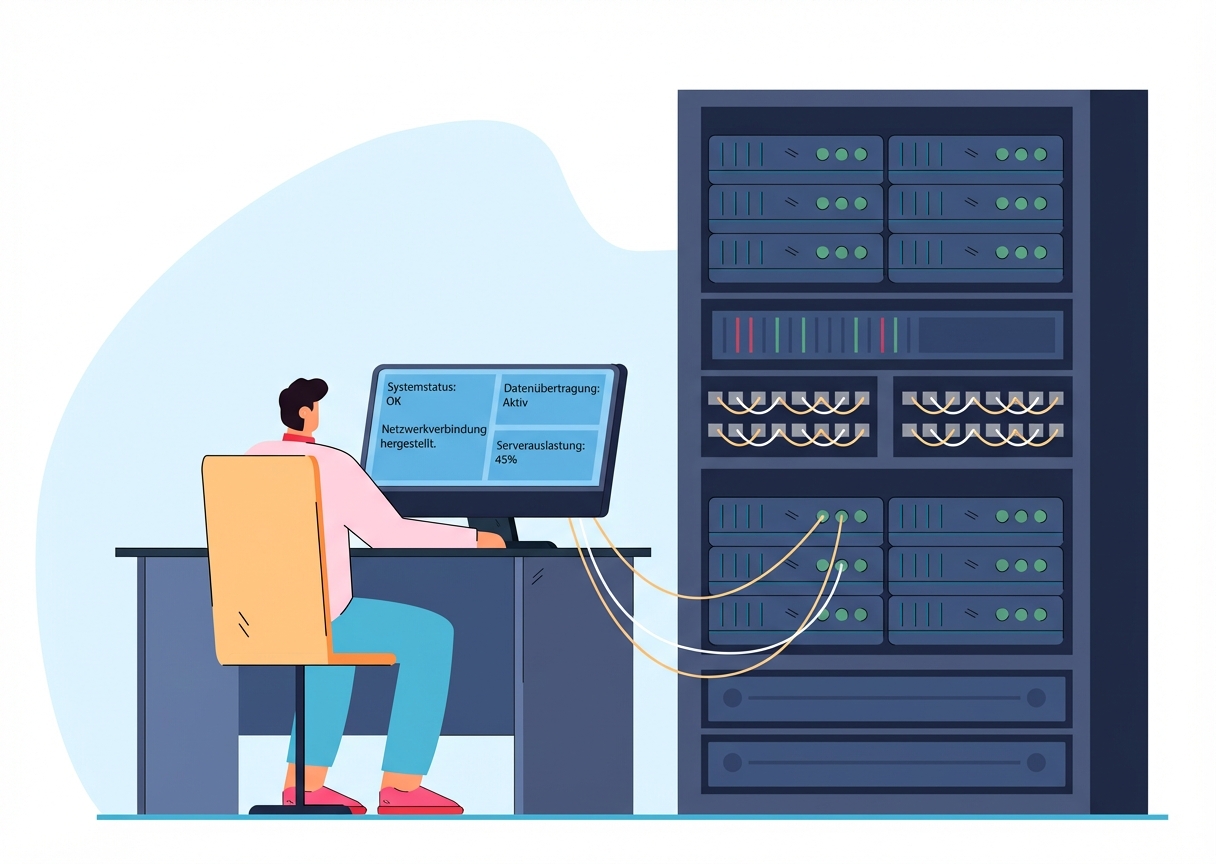

Rechenleistung

Speicher

Rechenleistung

Infrastruktur

Teuer

- LLM:

- Hundertausende CPUs

- Zehntausende Grafikprozessoren (GPUs)

- Ein PC: 4–8 CPUs und 1–2 GPUs

1 Freepik

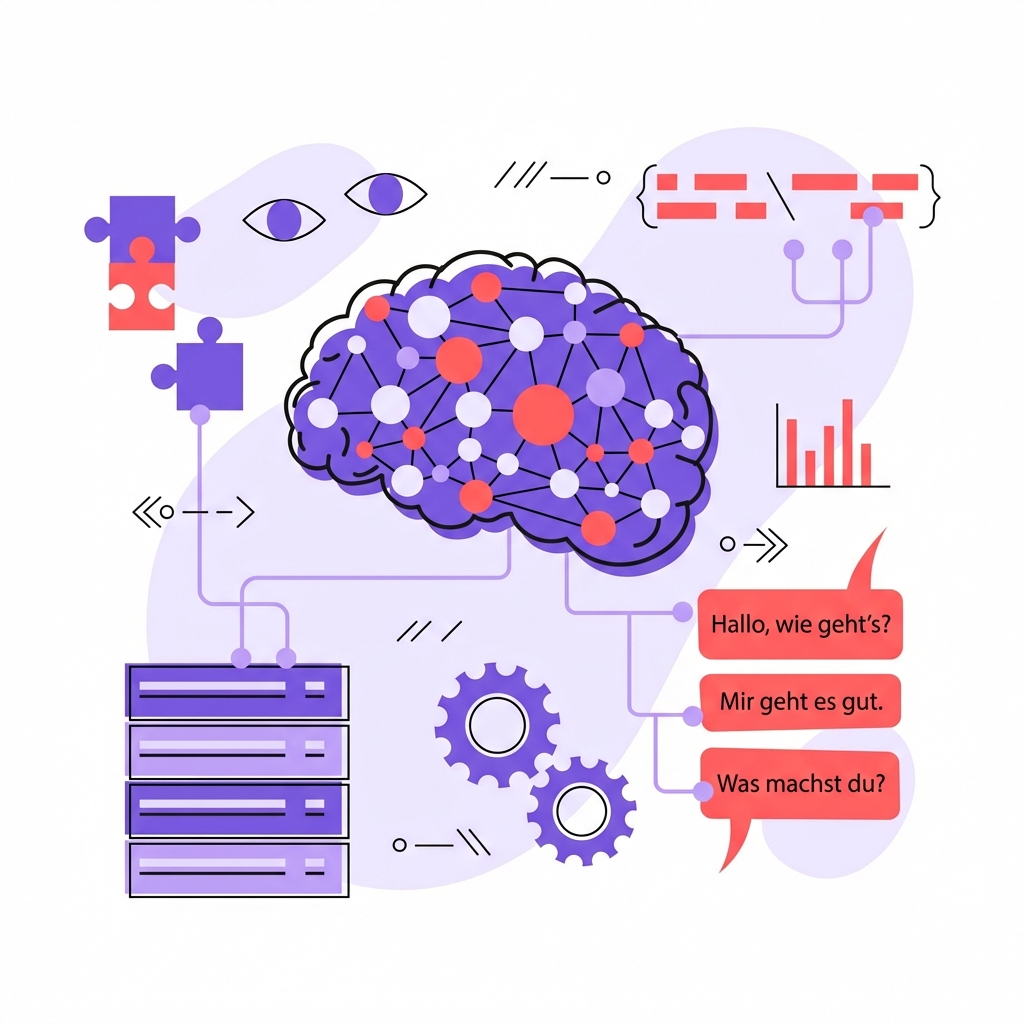

Effizientes Modelltraining

- Die Trainingszeit ist immens

- Kann Wochen oder sogar Monate dauern

- Effizientes Modelltraining = kürzere Trainingszeit

- 355 Jahre Rechenzeit auf einer einzigen GPU

Verfügbarkeit von Daten

- Bedarf an hochwertigen Daten

- Um die Komplexität und Feinheiten der Sprache zu lernen

Einige hundert Gigabyte (GB) Textdaten

- Über eine Million Bücher

Riesige Datenmenge

Die Herausforderungen meistern

- Fine-tuning

- Geht einige dieser Herausforderungen an

- Passt ein vortrainiertes Modell an

- Vortrainiertes Modell

- Hat aus allgemeinen Datensätzen gelernt

- Nicht für bestimmte Aufgaben optimiert

- Kann genau auf ein bestimmtes Problem abgestimmt werden

Fine-Tuning vs. Pre-Training

Fine-tuning

Rechenleistung

- 1-2 CPU und GPU

- Trainingszeit

- Stunden bis Tage

- Daten

- ~1 Gigabyte

Pre-Training

Rechenleistung

- Tausende von CPUs und GPUs

- Trainingszeit

- Wochen bis Monate

- Daten

- Hunderte von Gigabyte

Lass uns üben!

Konzepte großer Sprachmodelle (LLMs)