Der Transformer

Konzepte großer Sprachmodelle (LLMs)

Vidhi Chugh

AI strategist and ethicist

In welchem Abschnitt befinden wir uns?

Was ist ein Transformer?

- „Aufmerksamkeit ist alles, was du brauchst“

- Revolutionierte die Sprachmodellierung

- Transformerarchitektur

- Beziehung zwischen Wörtern

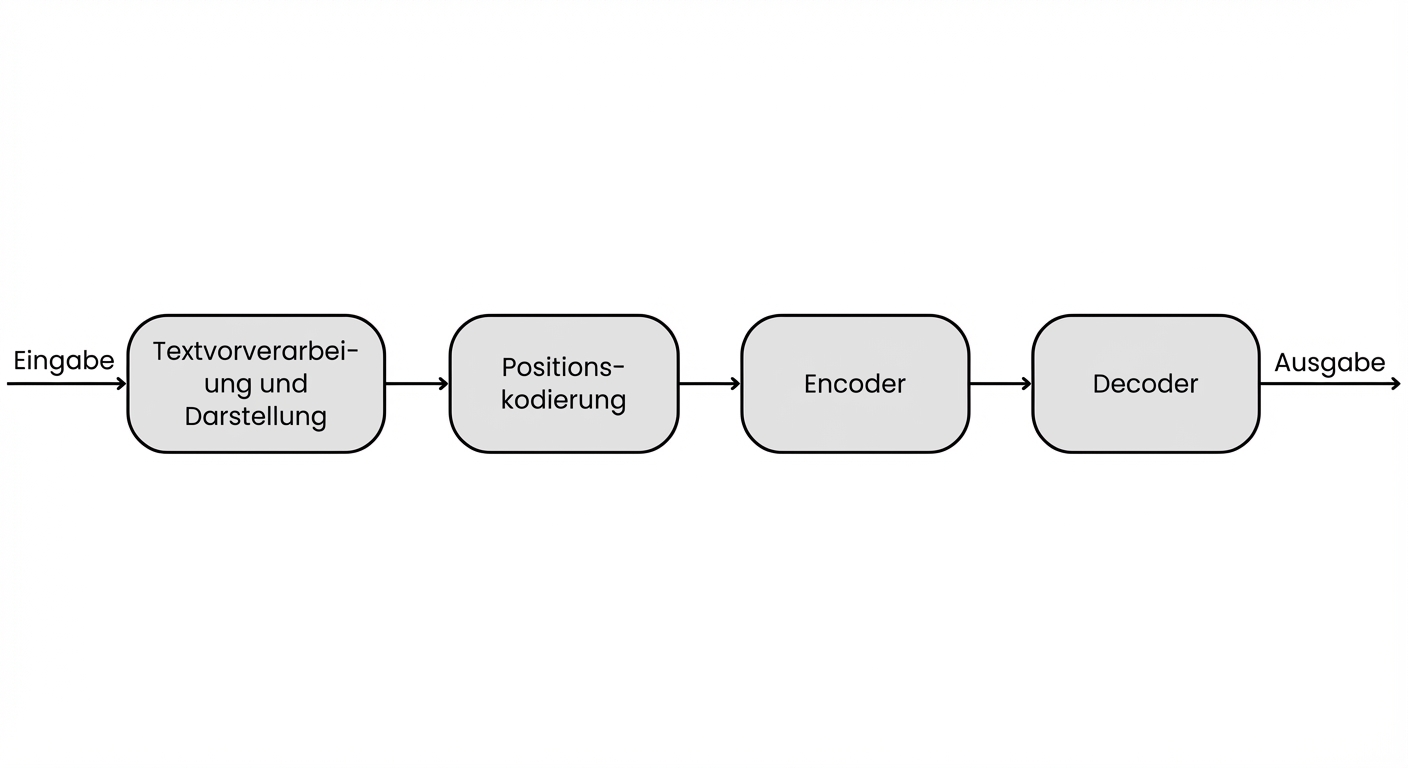

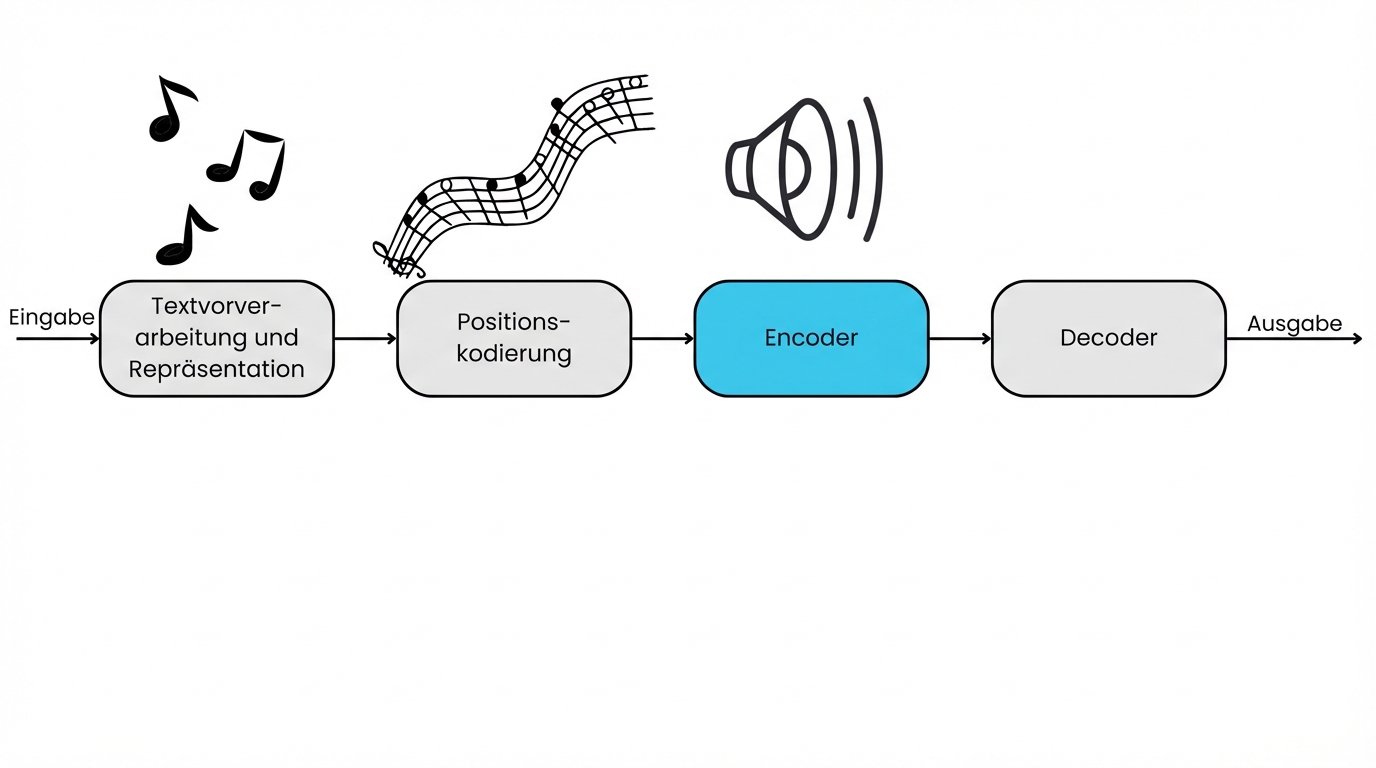

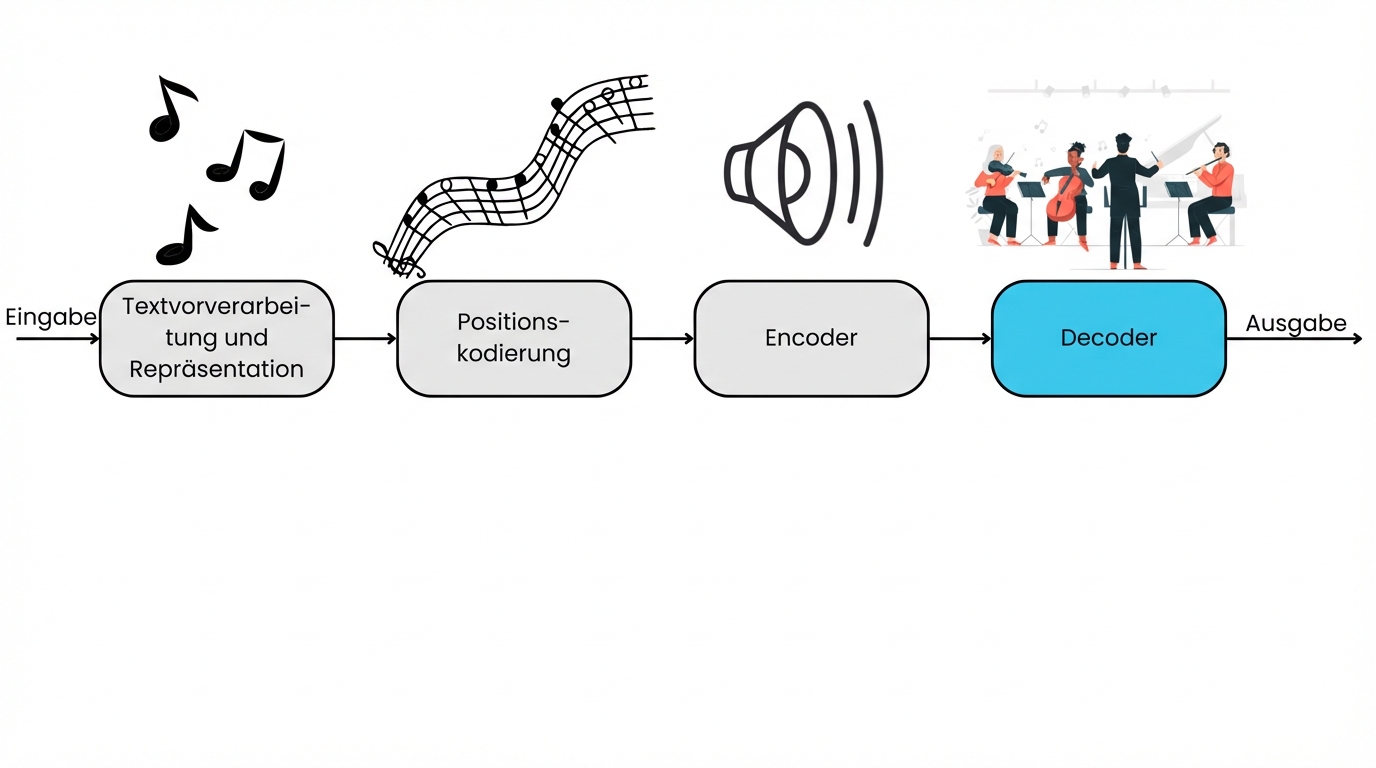

- Komponenten: Vorverarbeitung, Positionskodierung, Encoder und Decoder

1 arXiv: Attention Is All You Need

Im Inneren des Transformers

- Eingabe: Jane, die in New York wohnt und als Softwareentwicklerin arbeitet

- Ausgabe: Ingenieurin, liebt es, neue Restaurants in der Stadt zu entdecken.

Transformer sind wie ein Orchester

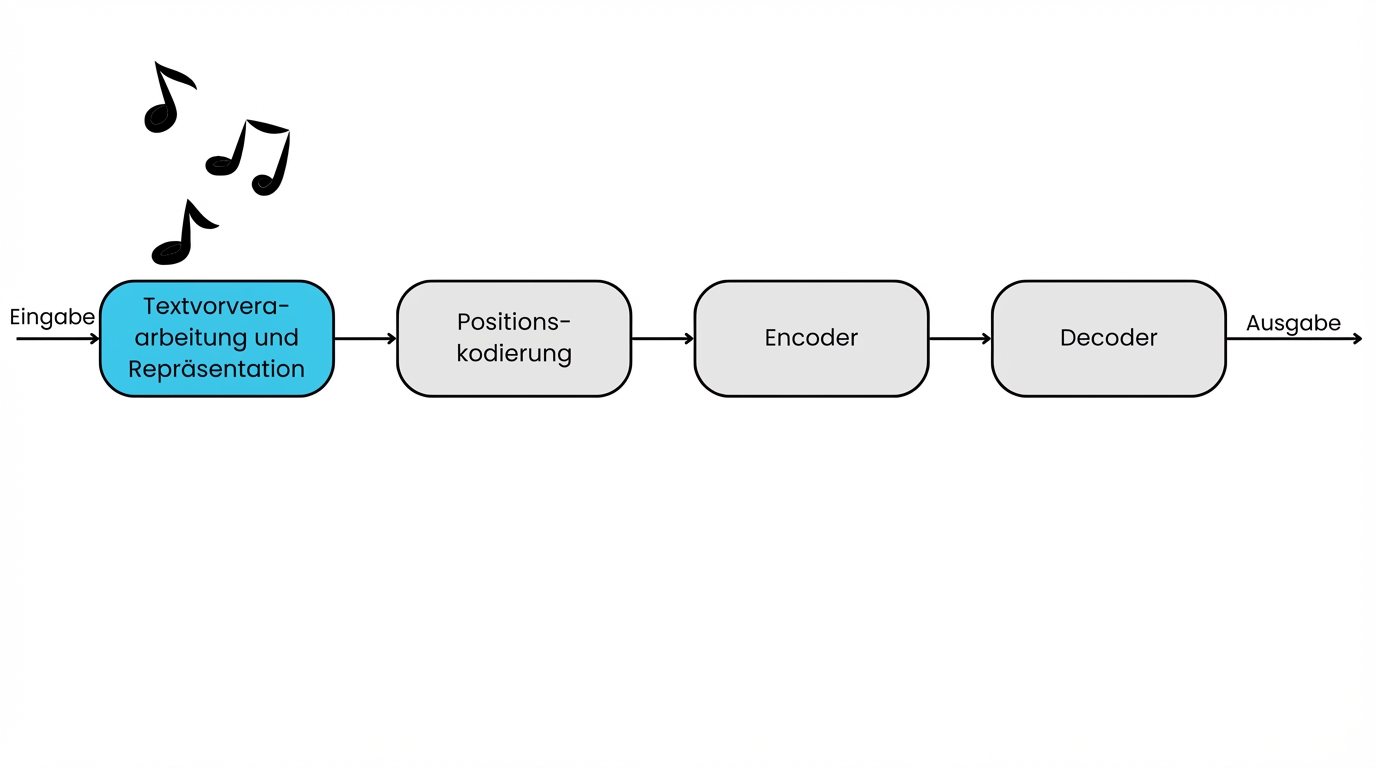

Textvorverarbeitung und -darstellung

- Textvorverarbeitung: Tokenisierung, Stoppwortentfernung, Lemmatisierung

- Textdarstellung: Worteinbettung

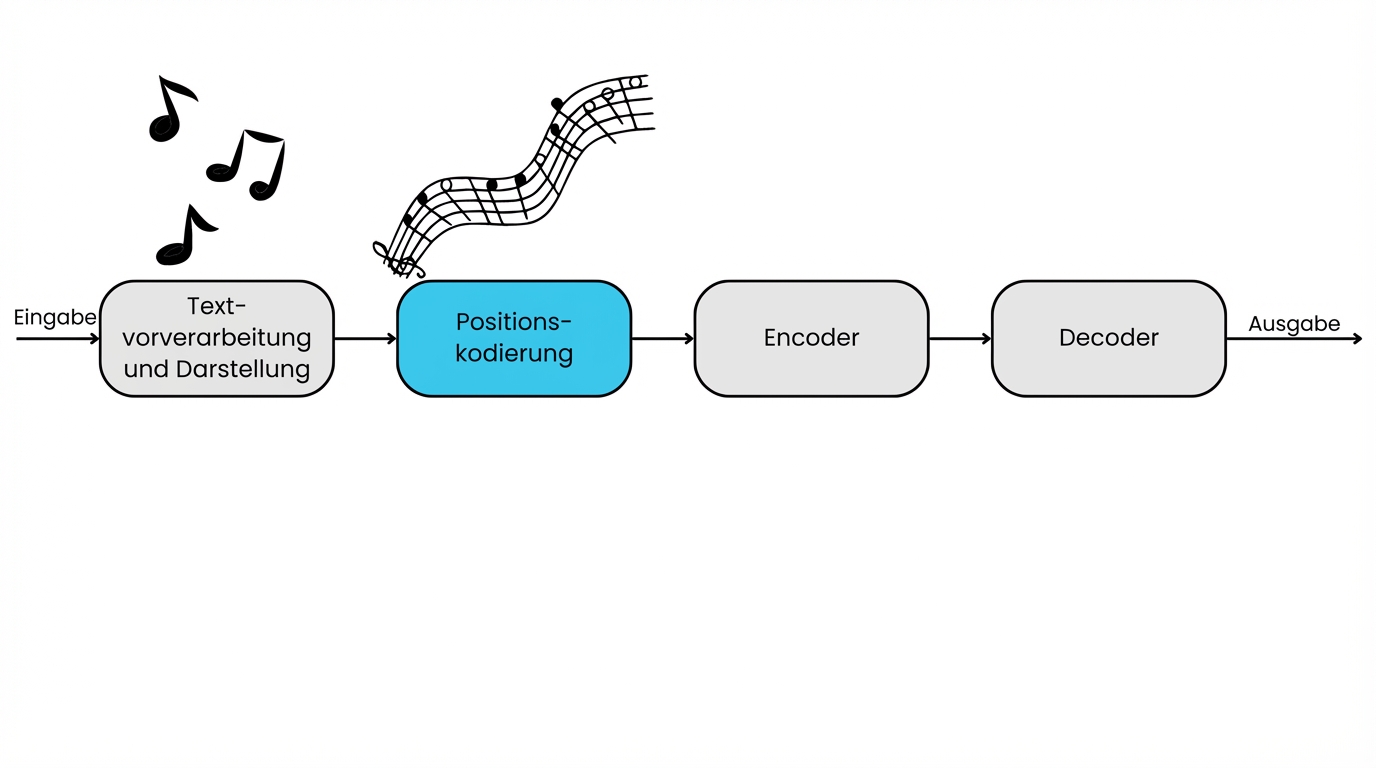

Positionskodierung

- Informationen zur Position jedes Wortes

- Versteht Zusammenhänge weit entfernter Wörter

Encoder

- Aufmerksamkeitsmechanismus: lenkt die Aufmerksamkeit auf bestimmte Wörter und Zusammenhänge

- Neuronales Netzwerk: Verarbeitet bestimmte Merkmale

Decoder

- Beinhaltet Aufmerksamkeitsmechanismen und neuronale Netzwerke

- Erzeugt die Ausgabe

Transformer und Beziehungen zwischen weit entfernten Wörtern

- Anfängliche Herausforderung: Beziehungen zwischen voneinander entfernten Wörtern

- Aufmerksamkeitsmechanismus: setzt den Fokus auf verschiedene Teile der Eingabe

Beispiel: „Jane wohnt in New York und arbeitet als Softwareentwicklerin. Sie liebt es, neue Restaurants in der Stadt zu entdecken.“

„Jane“ --- „liebt es, neue Restaurants auszuprobieren“

Gleichzeitige Prozessierung mehrere Teile

- Einschränkungen traditioneller Sprachmodelle:

- Sequenziell – ein Wort nach dem anderen

- Transformer:

- Gleichzeitige Prozessierung mehrerer Teile

- Schnellere Verarbeitung

- Zum Beispiel:

- „Die Katze saß auf der Matte.“

- Verarbeitet „Katze“, „saß“, „auf“, „der“ und „Matte“ gleichzeitig

Lass uns üben!

Konzepte großer Sprachmodelle (LLMs)