¿Es bueno tu modelo?

Aprendizaje supervisado con scikit-learn

George Boorman

Core Curriculum Manager, DataCamp

Métricas de clasificación

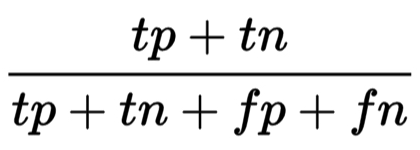

Medir el rendimiento del modelo con precisión:

Fracción de muestras clasificadas correctamente

No siempre es una métrica útil

Desequilibrio de clases

En una clasificación para predecir transacciones bancarias fraudulentas

- El 99 % de las transacciones son legítimas; el 1 % son fraudulentas

Se podría construir un clasificador que predijera que NINGUNA de las transacciones son fraudulentas

Y obtendría un ¡99% de precisión!

Pero sería desastroso en cuanto a predecir las transacciones que sí son fraudulentas

Fracasa en su propósito original

Desequilibrio de clases: frecuencia desigual de las clases

Es necesaria otra forma de evaluar el rendimiento

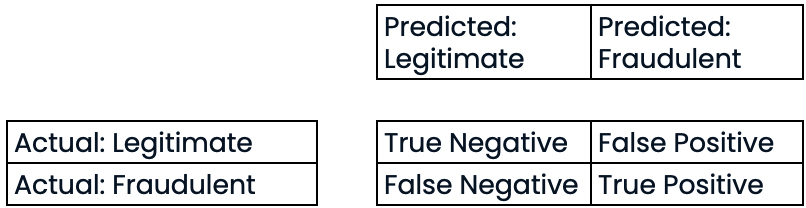

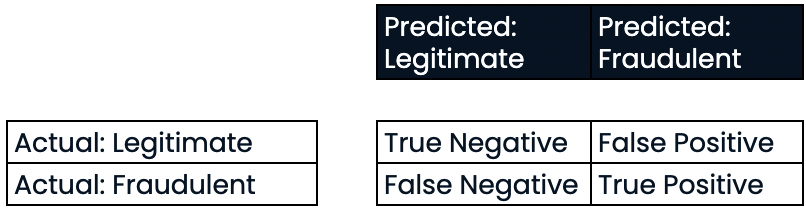

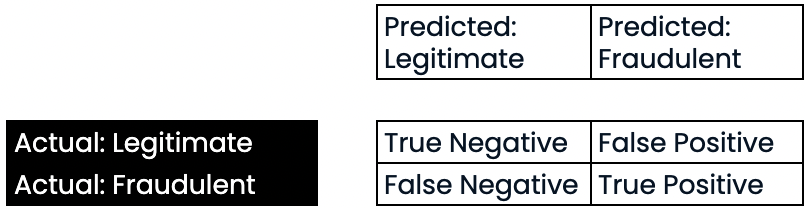

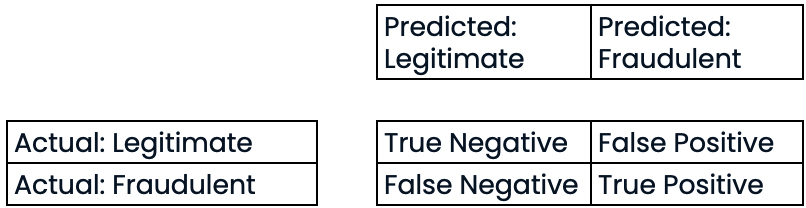

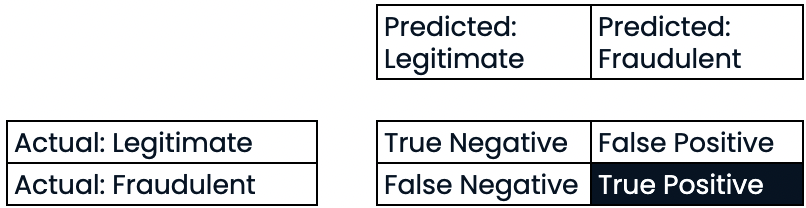

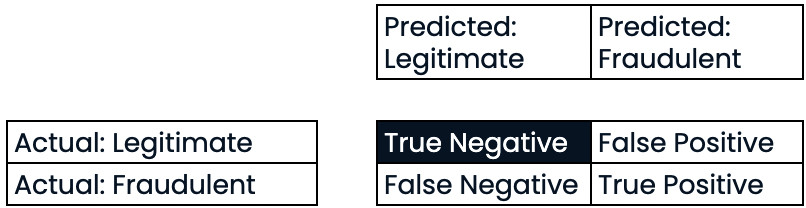

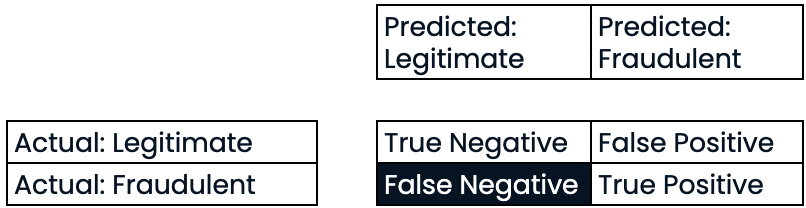

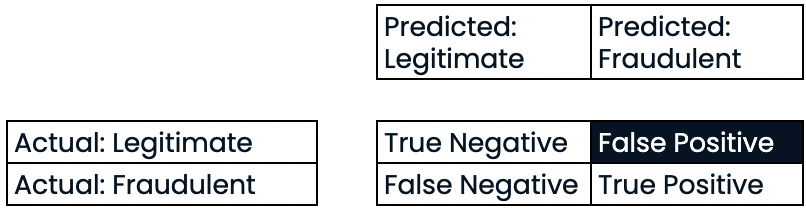

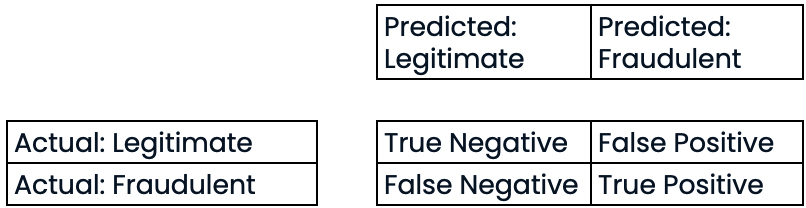

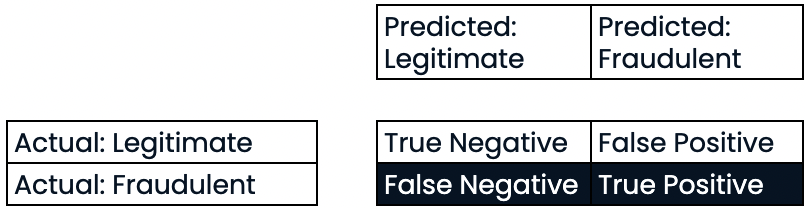

Matriz de confusión para evaluar el rendimiento de la clasificación

- Matriz de confusión

Evaluar el rendimiento de la clasificación

Evaluar el rendimiento de la clasificación

Evaluar el rendimiento de la clasificación

Evaluar el rendimiento de la clasificación

Evaluar el rendimiento de la clasificación

Evaluar el rendimiento de la clasificación

Evaluar el rendimiento de la clasificación

Evaluar el rendimiento de la clasificación

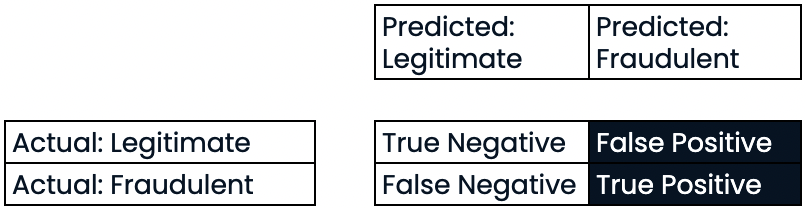

- Precisión:

Precisión

- Precisión

- Alta precisión = menor tasa de falsos positivos

- Con una alta precisión, no se prevé que muchas transacciones legítimas sean fraudulentas.

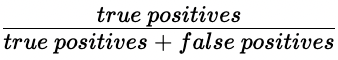

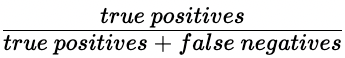

Sensibilidad o exhaustividad (recall))

- Sensibilidad o exhaustividad (recall)

- Alta exhaustividad = menor tasa de falsos negativos

- Con una alta exhaustividad, se predijeron correctamente la mayoría de las transacciones fraudulentas.

Puntuación F1

- Puntuación F1 = $2 * \frac{precision \ * \ recall}{precision \ + \ recall}$

Matriz de confusión en scikit-learn

from sklearn.metrics import classification_report, confusion_matrixknn = KNeighborsClassifier(n_neighbors=7)X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.4, random_state=42)knn.fit(X_train, y_train)y_pred = knn.predict(X_test)

Matriz de confusión en scikit-learn

print(confusion_matrix(y_test, y_pred))

[[1106 11]

[ 183 34]]

Informe de clasificación en scikit-learn

print(classification_report(y_test, y_pred))

precision recall f1-score support

0 0.86 0.99 0.92 1117

1 0.76 0.16 0.26 217

accuracy 0.85 1334

macro avg 0.81 0.57 0.59 1334

weighted avg 0.84 0.85 0.81 1334

¡Vamos a practicar!

Aprendizaje supervisado con scikit-learn