Einführung in das Prompt Engineering

Prompt-Engineering mit der OpenAI-API

Fouad Trad

Machine Learning Engineer

Was ist Prompt Engineering?

Erstellen von Prompts oder Anweisungen für LLMs, um die gewünschten Antworten zu bekommen.

Prompt Engineering ist wie das Erstellen eines Rezepts

Warum Prompt Engineering nutzen?

Warum Prompt Engineering nutzen?

Zusammenfassung: OpenAI-API

- Ermöglicht die Interaktion mit OpenAI-Modellen

- Bereits eingerichtet in diesem Kurs

- Zugang zum Chat-Completions Endpunkt

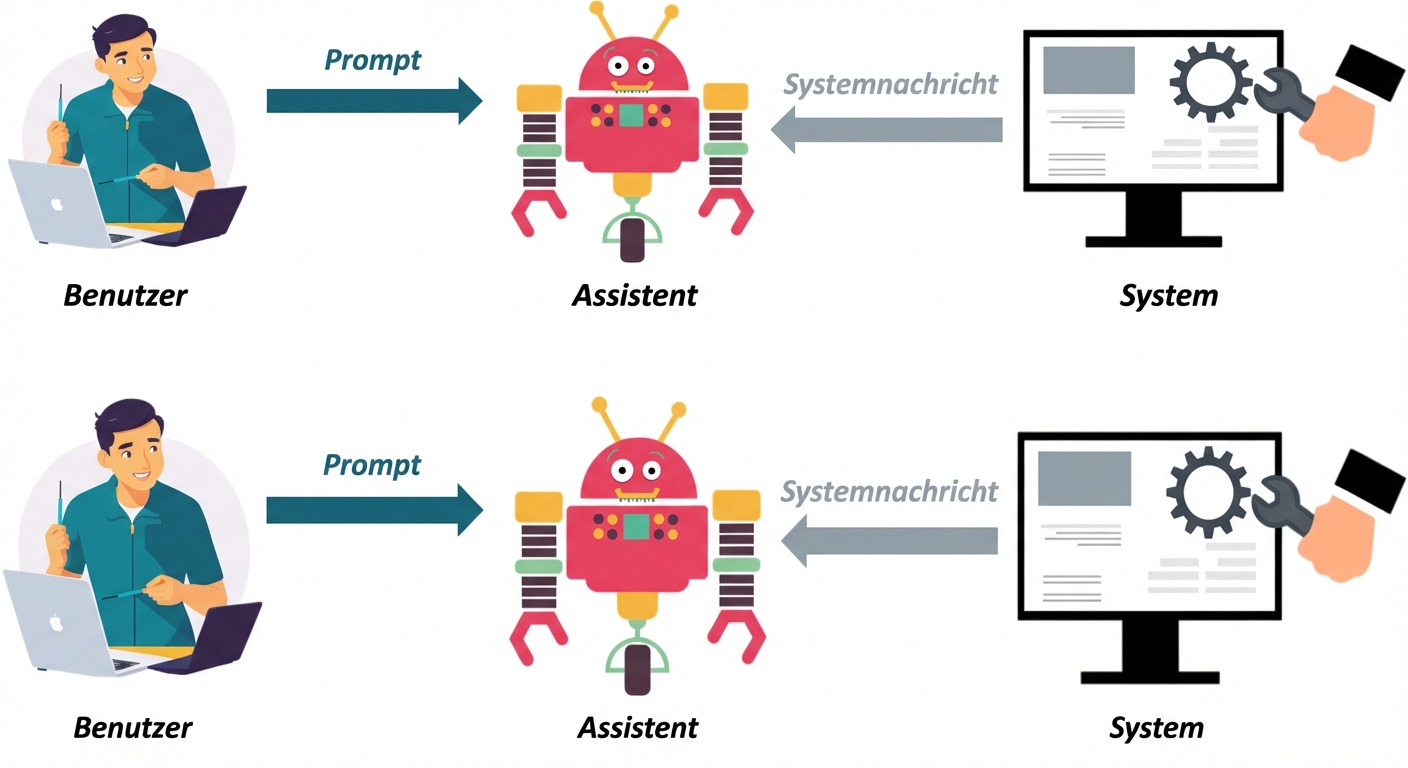

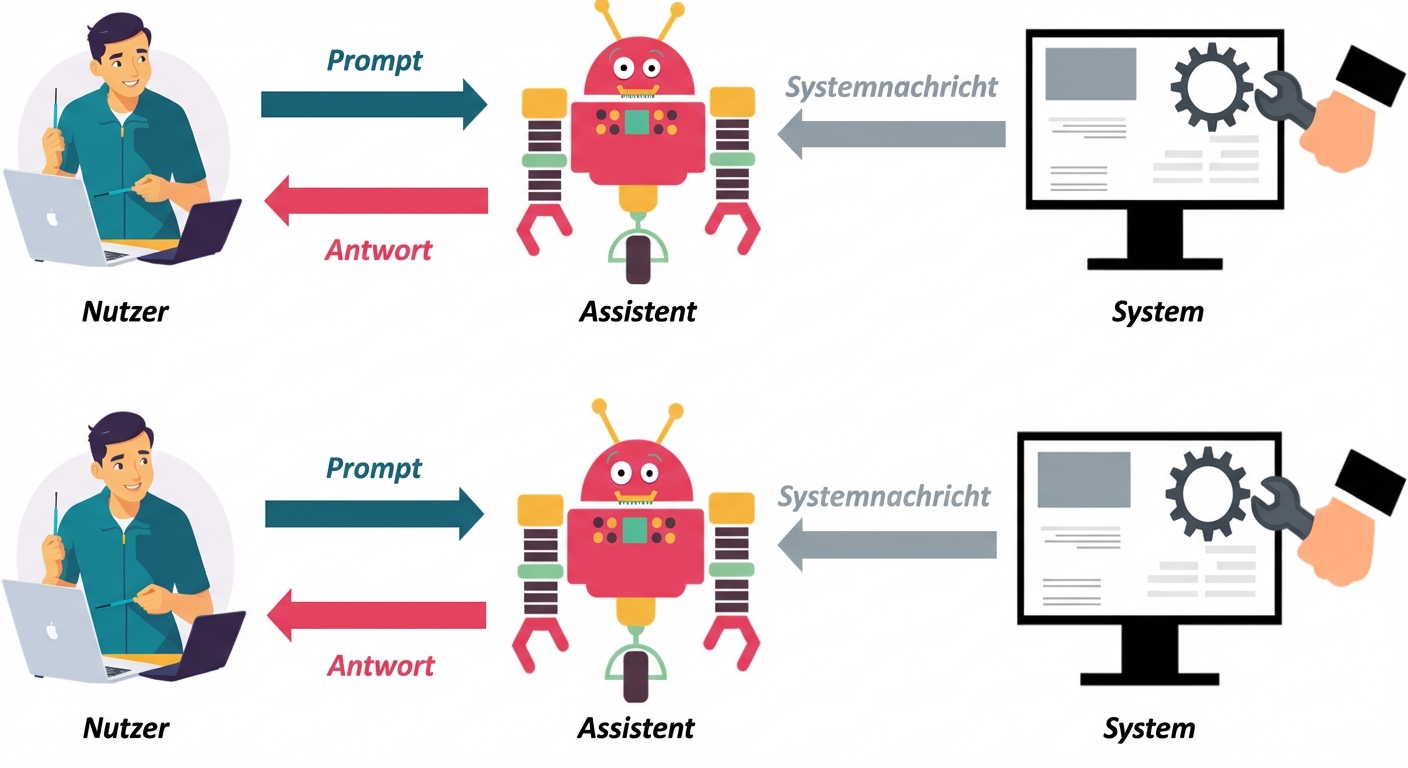

Zusammenfassung: Nachrichtenrollen

Jeder message-Typ hat eine von drei Rollen:

Zusammenfassung: Nachrichtenrollen

Jeder message-Typ hat eine von drei Rollen:

Zusammenfassung: Nachrichtenrollen

Jeder message-Typ hat eine von drei Rollen:

Zusammenfassung: Nachrichtenrollen

Jeder message-Typ hat eine von drei Rollen:

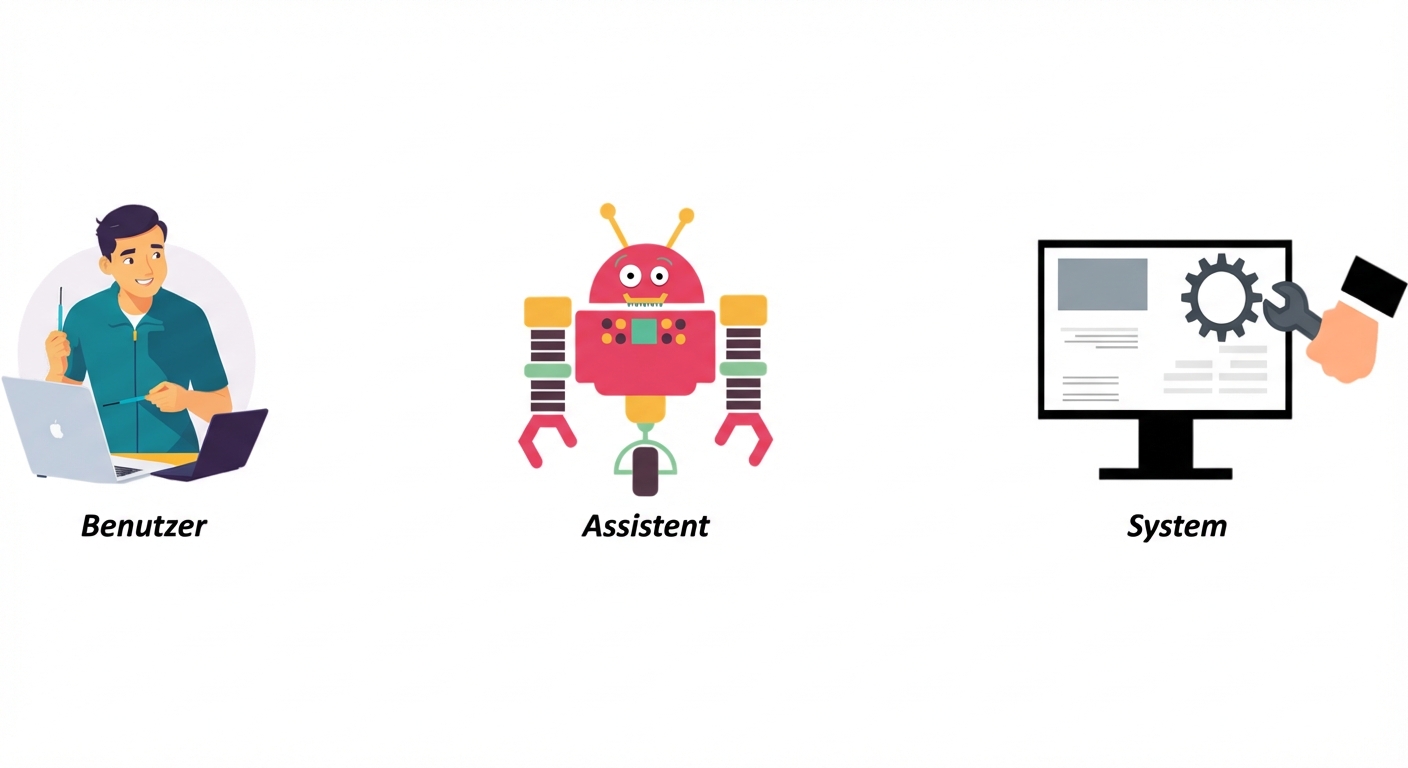

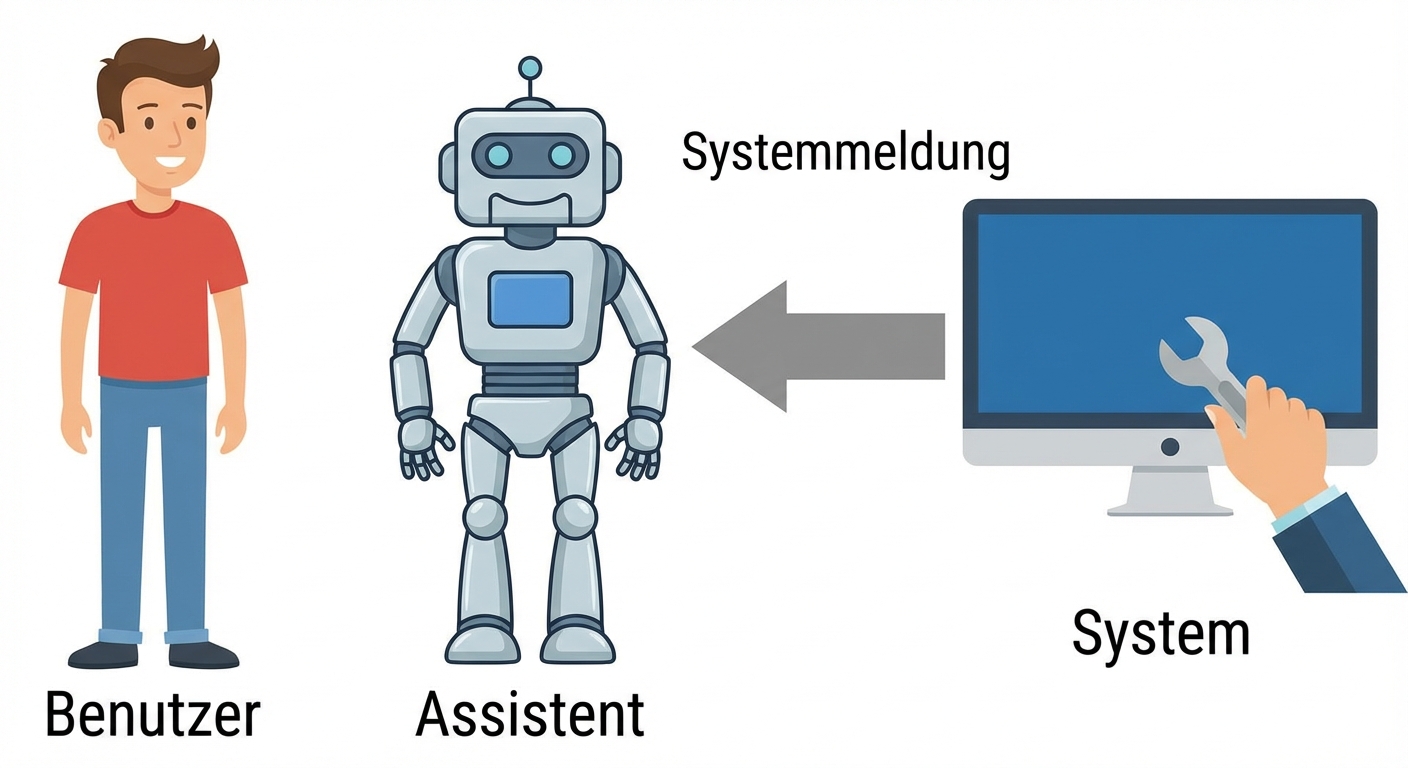

- System message: steuert Modellverhalten

Zusammenfassung: Nachrichtenrollen

Jeder message-Typ hat eine von drei Rollen:

- System message: steuert Modellverhalten

- User message: Prompt vom Nutzenden

Zusammenfassung: Nachrichtenrollen

Jeder message-Typ hat eine von drei Rollen:

- System message: steuert Modellverhalten

- User message: Prompt vom Nutzenden

- Assistant message: Antwort auf Nutzerprompt

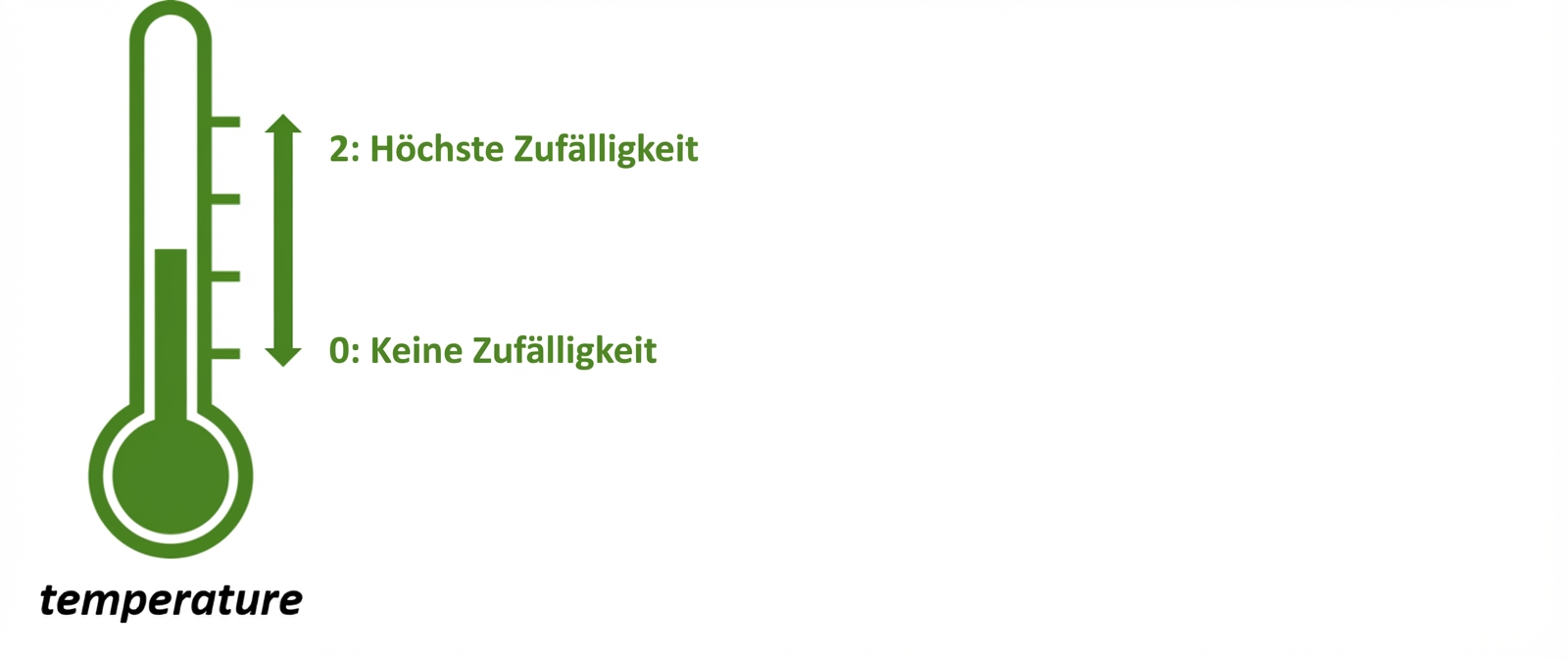

Zusammenfassung: Steuerungsparameter

temperature: regelt die Zufälligkeit der Antworten

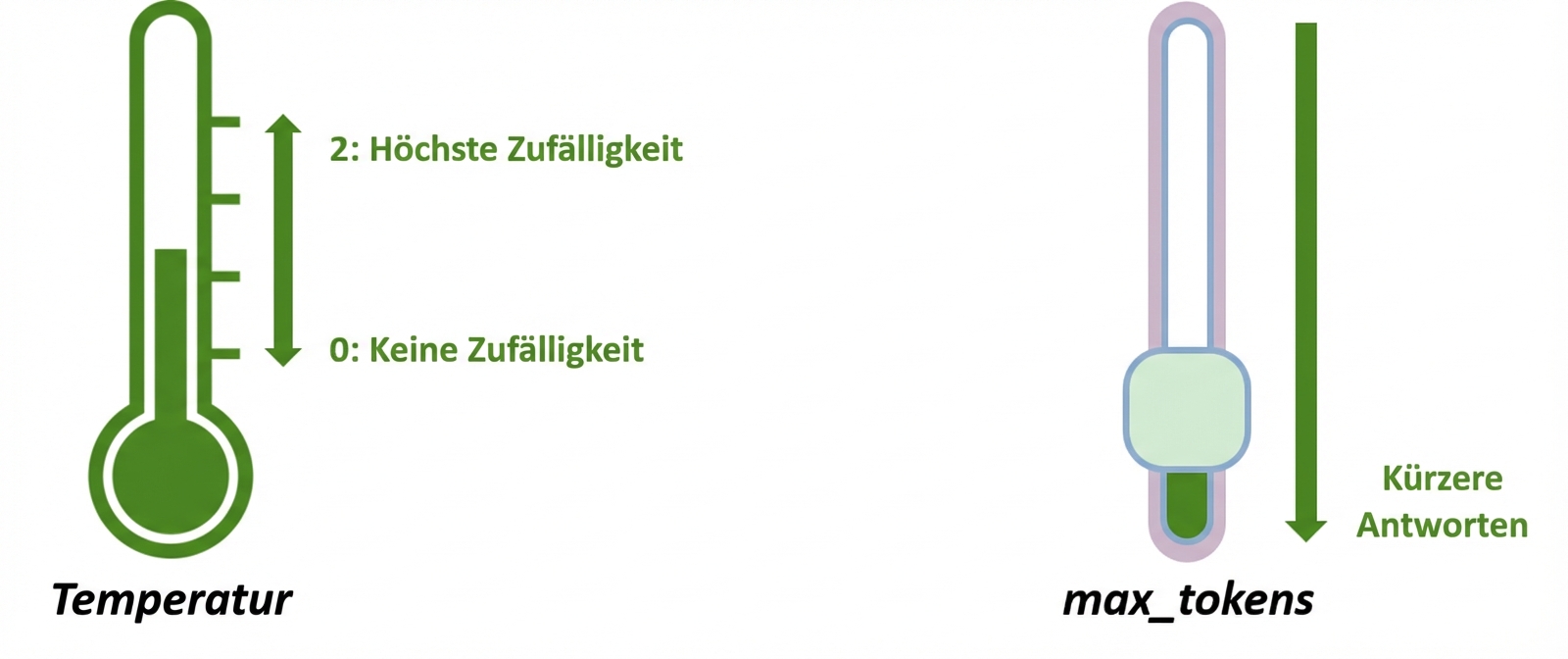

Zusammenfassung: Steuerungsparameter

temperature: regelt die Zufälligkeit der Antwortenmax_tokens: regelt die Antwortlänge

Zusammenfassung: Interaktion mit der OpenAI-API

prompt = "What is prompt engineering?"client = OpenAI(api_key="api_key")response = client.chat.completions.create(model = "gpt-3.5-turbo",messages = [{"role": "user", "content": prompt}],temperature = 0 )print(response.choices[0].message.content)

Prompt engineering refers to the process of designing and refining prompts or

instructions given to a language model like ChatGPT in order to elicit desired

responses or behaviors. It involves formulating specific guidelines or hints to

guide the model's output towards a desired outcome.

Erstellen der Funktion get_response()

def get_response(prompt):response = client.chat.completions.create( model = "gpt-3.5-turbo", messages = [{"role": "user", "content": prompt}], temperature = 0 )return response.choices[0].message.content

Verwendung

response = get_response("What is prompt engineering?")

print(response)

Prompt engineering refers to the process of designing and refining prompts or instructions given to a language model

like ChatGPT in order to elicit desired responses or behaviors. It involves formulating specific guidelines or hints

to guide the model's output towards a desired outcome.

Schnelle Verbesserung

prompt = "What is prompt engineering? Explain it in terms that can be understood

by a 5-year-old"

response = get_response(prompt)

print(response)

Imagine you have a very smart friend who can understand and answer lots of

questions. But sometimes, they might not understand exactly what you want or give

the wrong answer. So, prompt engineering is like giving your friend really clear

instructions or hints to help them give you the best answer possible.

Lass uns üben!

Prompt-Engineering mit der OpenAI-API