Les bases de la régression linéaire

Apprentissage supervisé avec scikit-learn

George Boorman

Core Curriculum Manager, DataCamp

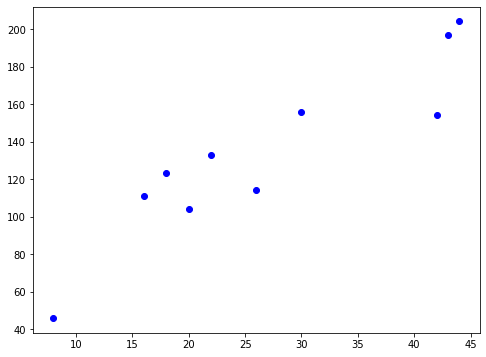

Mécanisme de régression

$y = ax + b$

La régression linéaire simple utilise une caractéristique

$y$ = cible

$x$ = caractéristique unique

$a$, $b$ = paramètres/coefficients du modèle : pente, ordonnée à l’origine

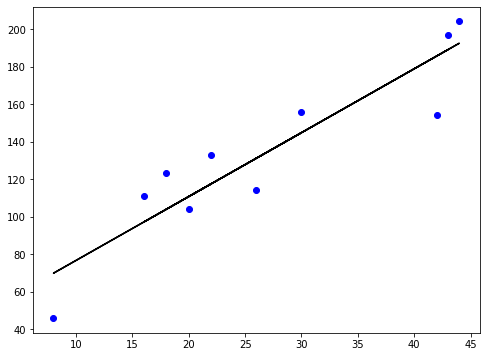

Comment choisir $a$ et $b$ ?

Définissez une fonction d’erreur pour une ligne donnée

Choisissez la ligne qui minimise la fonction d’erreur

Fonction d’erreur = fonction de perte = fonction de coût

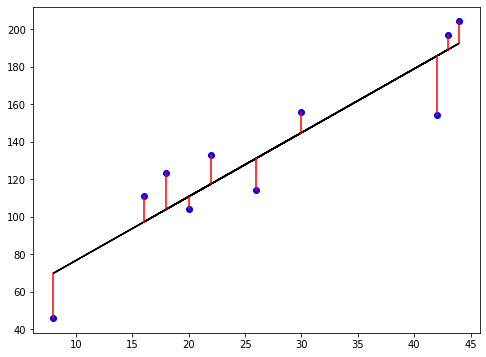

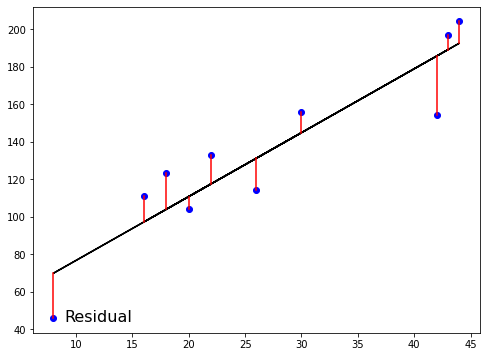

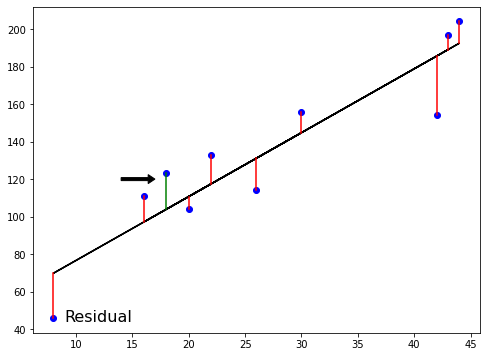

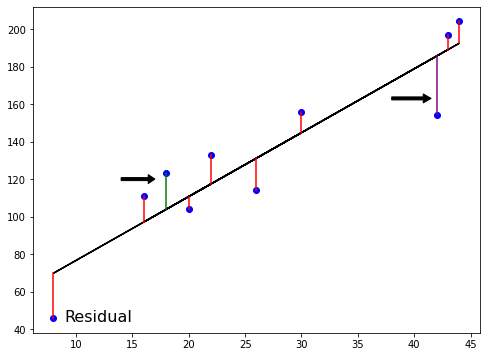

La fonction de perte

La fonction de perte

La fonction de perte

La fonction de perte

La fonction de perte

Moindres carrés ordinaires

$RSS = $ $\displaystyle\sum_{i=1}^{n}(y_i-\hat{y_i})^2$

Moindres carrés ordinaires (MCO) : minimiser RSS

Régression linéaire dans des dimensions supérieures

$$ y = a_{1}x_{1} + a_{2}x_{2} + b$$

- Pour ajuster un modèle de régression linéaire ici :

- Vous devez spécifier 3 variables : $ a_1,\ a_2,\ b $.

- Dans des dimensions supérieures :

- Connu sous le nom de régression multiple

- Vous devez spécifier les coefficients pour chaque caractéristique et la variable $b$

$$ y = a_{1}x_{1} + a_{2}x_{2} + a_{3}x_{3} +... + a_{n}x_{n}+ b$$

- scikit-learn fonctionne exactement de la même manière :

- Passez deux tableaux : les caractéristiques et la cible

Régression linéaire utilisant toutes les caractéristiques

from sklearn.model_selection import train_test_split from sklearn.linear_model import LinearRegressionX_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)reg_all = LinearRegression()reg_all.fit(X_train, y_train)y_pred = reg_all.predict(X_test)

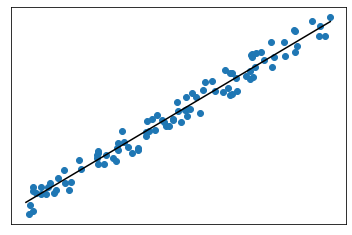

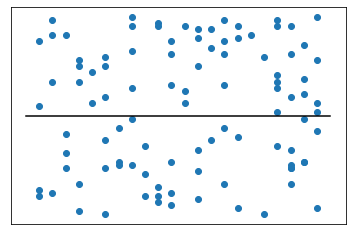

R-carré

$R^2$ : quantifie la variance des valeurs cibles expliquée par les caractéristiques

- Les valeurs sont comprises entre 0 et 1

$R^2$ élevé :

- $R^2$ faible :

R-carré dans scikit-learn

reg_all.score(X_test, y_test)

0.356302876407827

Erreur quadratique moyenne (MSE) et racine de l’erreur quadratique moyenne (RMSE)

$MSE = $ $\displaystyle\frac{1}{n}\sum_{i=1}^{n}(y_i-\hat{y_i})^2$

- Le $MSE$ est mesuré en unités cible, au carré

$RMSE = $ $\sqrt{MSE}$

- Le $RMSE$ se mesure dans les mêmes unités que la variable cible

RMSE dans scikit-learn

from sklearn.metrics import root_mean_squared_errorroot_mean_squared_error(y_test, y_pred)

24.028109426907236

Passons à la pratique !

Apprentissage supervisé avec scikit-learn