Réglage des hyperparamètres

Apprentissage supervisé avec scikit-learn

George Boorman

Core Curriculum Manager

Réglage des hyperparamètres

Régression de crête/lasso : choisir

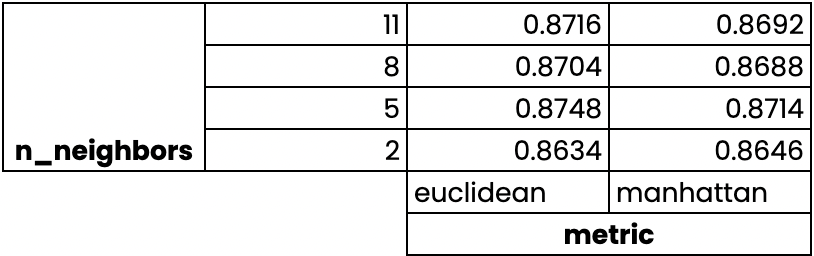

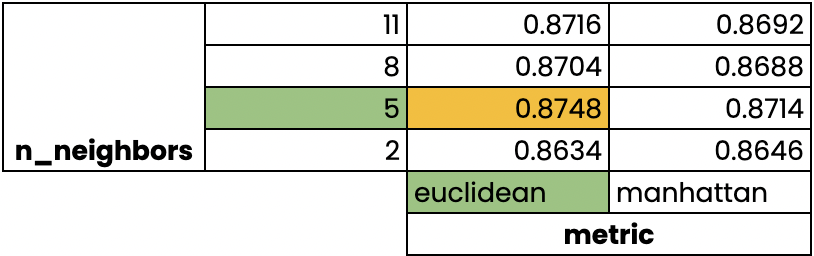

alphaKNN : choisir

n_neighborsHyperparamètres : paramètres spécifiés avant l’ajustement du modèle

- Comme

alphaetn_neighbors

- Comme

Choisir les bons hyperparamètres

Essayez un grand nombre de valeurs d’hyperparamètres

Ajustez toutes les valeurs séparément

Examinez leurs performances

Choisissez les valeurs les plus performantes

C’est ce qu’on appelle le réglage des hyperparamètres

Il est essentiel d’utiliser la validation croisée pour éviter un surajustement de l’ensemble de test

Nous pouvons diviser les données et effectuer une validation croisée sur l’ensemble d’apprentissage

Nous conservons l’ensemble de test pour l’évaluation finale

Validation croisée par recherche de grille

Validation croisée par recherche de grille

Validation croisée par recherche de grille

GridSearchCV dans scikit-learn

from sklearn.model_selection import GridSearchCVkf = KFold(n_splits=5, shuffle=True, random_state=42)param_grid = {"alpha": np.arange(0.0001, 1, 10), "solver": ["sag", "lsqr"]}ridge = Ridge()ridge_cv = GridSearchCV(ridge, param_grid, cv=kf)ridge_cv.fit(X_train, y_train)print(ridge_cv.best_params_, ridge_cv.best_score_)

{'alpha': 0.0001, 'solver': 'sag'}

0.7529912278705785

Limites et approche alternative

- Validation croisée à 3 blocs, 1 hyperparamètre, 10 valeurs totales = 30 ajustements

- Validation croisée à 10 blocs, 3 hyperparamètres, 30 valeurs totales = 900 ajustements

RandomizedSearchCV

from sklearn.model_selection import RandomizedSearchCVkf = KFold(n_splits=5, shuffle=True, random_state=42) param_grid = {'alpha': np.arange(0.0001, 1, 10), "solver": ['sag', 'lsqr']} ridge = Ridge()ridge_cv = RandomizedSearchCV(ridge, param_grid, cv=kf, n_iter=2) ridge_cv.fit(X_train, y_train)print(ridge_cv.best_params_, ridge_cv.best_score_)

{'solver': 'sag', 'alpha': 0.0001}

0.7529912278705785

Évaluation sur l’ensemble de test

test_score = ridge_cv.score(X_test, y_test)print(test_score)

0.7564731534089224

Passons à la pratique !

Apprentissage supervisé avec scikit-learn