Fonctions d’activation ReLU

Introduction au deep learning avec PyTorch

Jasmin Ludolf

Senior Data Science Content Developer, DataCamp

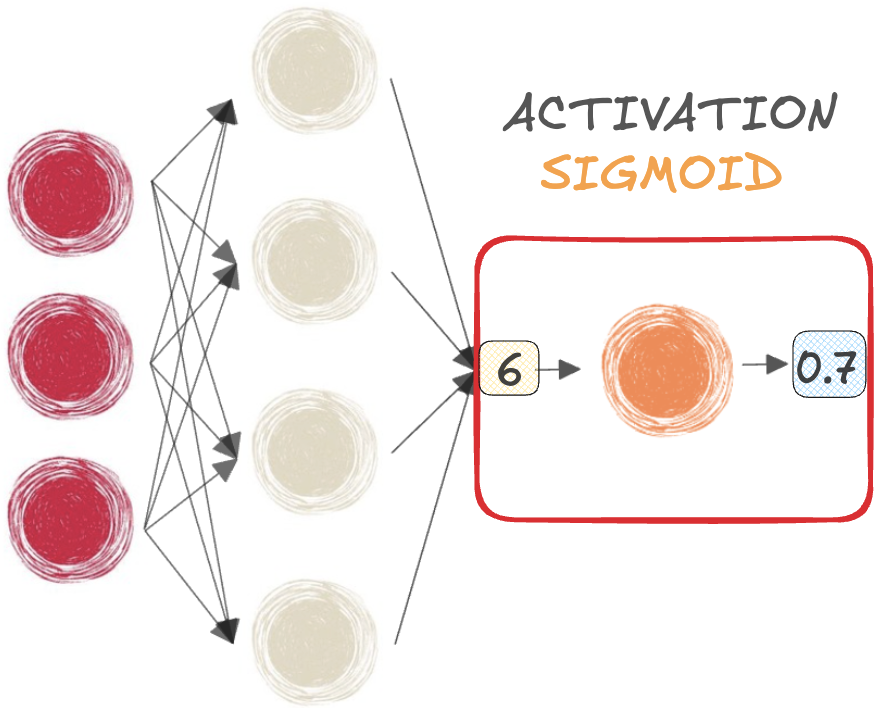

Fonctions sigmoïde et softmax

$$

- SIGMOÏDE pour la classification BINAIRE

$$

- SOFTMAX pour la classification MULTI-CLASSE

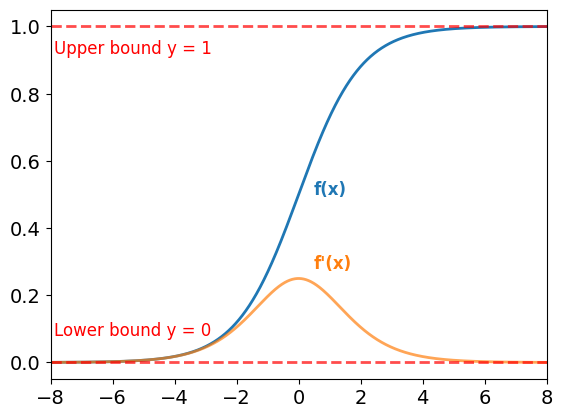

Limites des fonctions sigmoïde et softmax

Fonction sigmoïde :

- Sorties comprises entre 0 et 1

- Utilisable partout dans un réseau

Gradients :

- Très faible pour les petites et grandes valeurs de x

- Cause de saturation, entraînant le problème des gradients qui s’évanouissent.

$$

Softmax souffre aussi de saturation

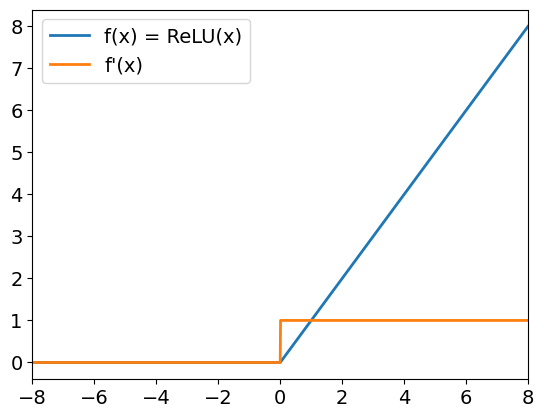

ReLU

Unité linéaire**rectifiée**(ReLU) :

f(x) = max(x, 0)- Entrées positives : la sortie = l’entrée

- Entrées négatives : la sortie est 0

- Limite la disparition des gradients

$$

Dans PyTorch :

relu = nn.ReLU()

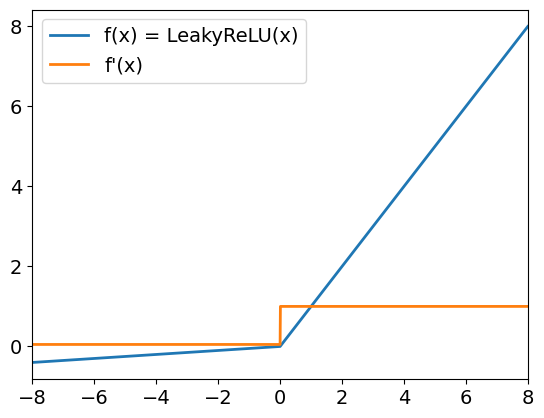

Leaky ReLU

Leaky ReLU :

- Les entrées positives se comportent avec ReLU

- Les entrées négatives sont mises à l’échelle par un petit coefficient (par défaut 0,01).

- Les gradients pour les entrées négatives sont non nuls

$$

Dans PyTorch :

leaky_relu = nn.LeakyReLU(

negative_slope = 0.05)

Passons à la pratique !

Introduction au deep learning avec PyTorch