Metriken für Sprachaufgaben: Perplexity und BLEU

Einführung in LLMs mit Python

Jasmin Ludolf

Senior Data Science Content Developer, DataCamp

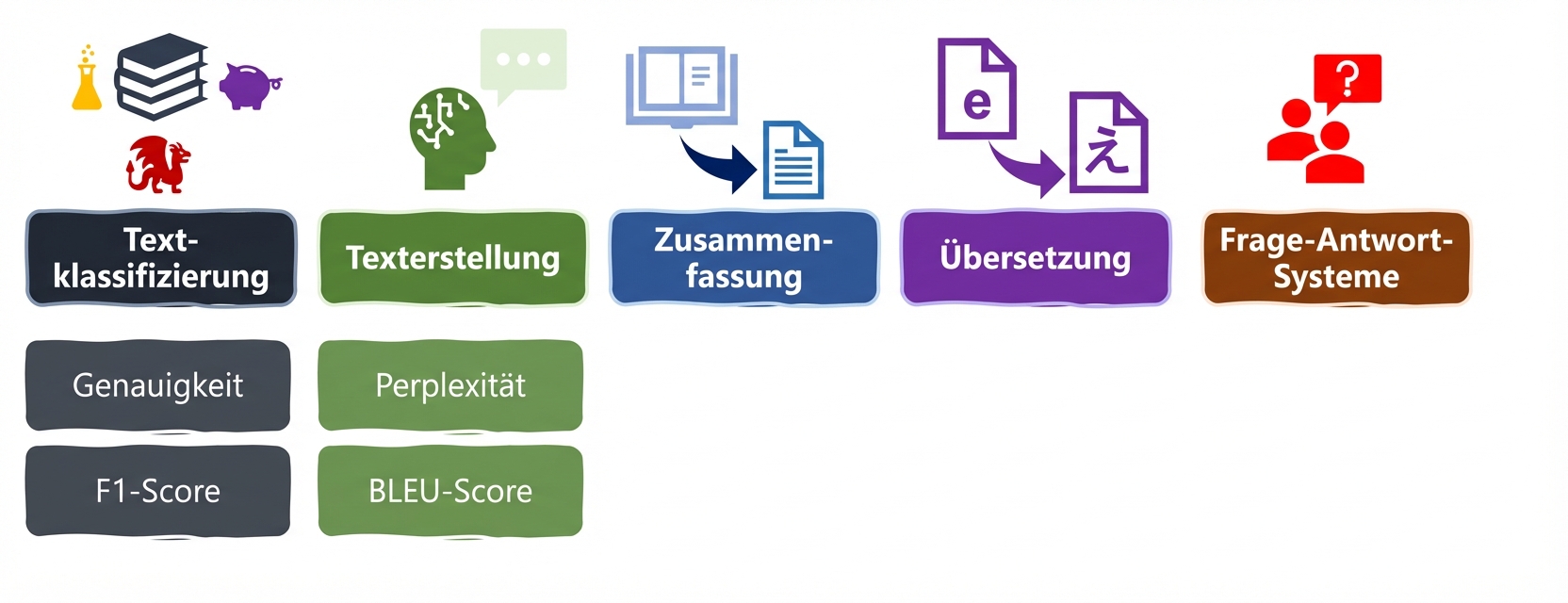

LLM-Aufgaben und Metriken

Perplexity

- Die Fähigkeit eines Modells, das nächste Wort genau und sicher vorherzusagen

- Niedriger Perplexity-Wert = mehr Vertrauen

input_text = "Latest research findings in Antarctica show" generated_text = "Latest research findings in Antarctica show that the ice sheet is melting faster than previously thought."# Encode the prompt, generate text and decode it input_text_ids = tokenizer.encode(input_text, return_tensors="pt") output = model.generate(input_text_ids, max_length=20) generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

Perplexity-Ausgabe

perplexity = evaluate.load("perplexity", module_type="metric") results = perplexity.compute(predictions=generated_text, model_id="gpt2")print(results)

{'perplexities': [245.63299560546875, 520.3106079101562, ....],

'mean_perplexity': 2867.7229790460497}

print(results["mean_perplexity"])

2867.7229790460497

- Vergleich mit den Basiswerten

BLEU

Vergleicht Übersetzungsqualität mit menschlichen Referenzen

Prognosen: LLM-Ergebnisse

- Referenzen: vom Menschen bereitgestellt

bleu = evaluate.load("bleu")input_text = "Latest research findings in Antarctica show" references = [["Latest research findings in Antarctica show significant ice loss due to climate change.", "Latest research findings in Antarctica show that the ice sheet is melting faster than previously thought."]] generated_text = "Latest research findings in Antarctica show that the ice sheet is melting faster than previously thought."

BLEU-Ausgabe

results = bleu.compute(predictions=[generated_text], references=references)

print(results)

{'bleu': 1.0,

'precisions': [1.0, 1.0, 1.0, 1.0],

'brevity_penalty': 1.0,

'length_ratio': 1.2142857142857142,

'translation_length': 17,

'reference_length': 14}

- Wert zwischen 0 und 1: näher an 1 = höhere Ähnlichkeit

Lass uns üben!

Einführung in LLMs mit Python