Vortrainierte LLMs nutzen

Einführung in LLMs mit Python

Jasmin Ludolf

Senior Data Science Content Developer, DataCamp

Sprachverständnis

Sprachgenerierung

Textgenerierung

generator = pipeline(task="text-generation", model="distilgpt2")

prompt = "The Gion neighborhood in Kyoto is famous for"

output = generator(prompt, max_length=100, pad_token_id=generator.tokenizer.eos_token_id)

- Zusammenhängender Text

- Sinnvoller Text

- Menschlich klingender Text

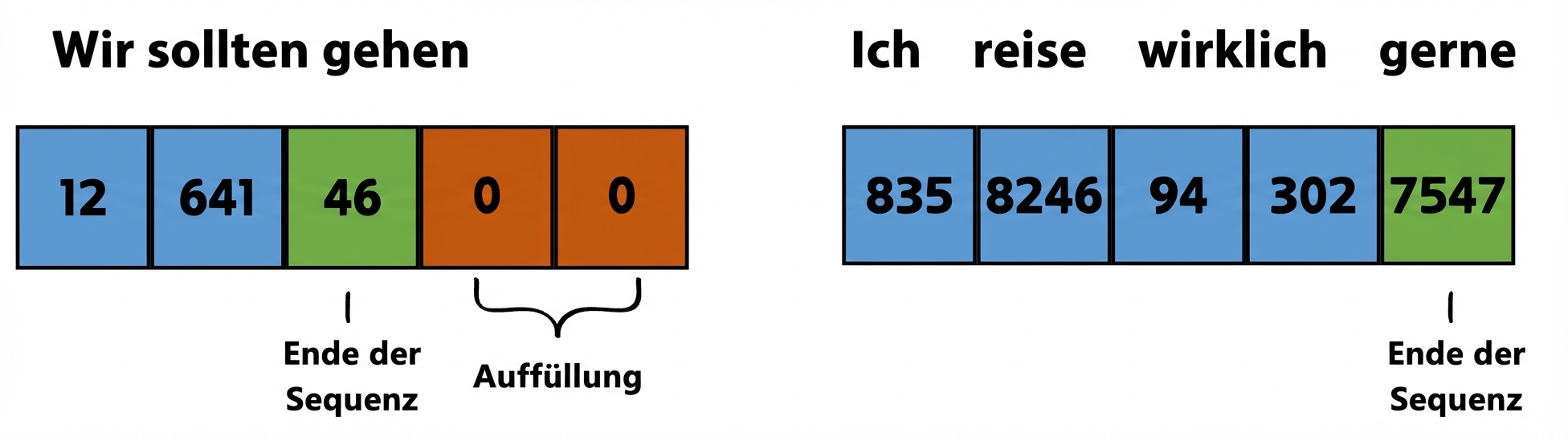

eos_token_id: Kennung für das End-of-Sequence-Token

Textgenerierung

pad_token_idfüllt den zusätzlichen Platz bis zumax_length- Padding fügt Tokens hinzu

- Im Training gelernte

generator.tokenizer.eos_token_idmarkiert Ende von sinnvollem Text - Modell erzeugt bis zu

max_lengthoderpad_token_id truncation = True

Textgenerierung

generator = pipeline(task="text-generation", model="distilgpt2") prompt = "The Gion neighborhood in Kyoto is famous for" output = generator(prompt, max_length=100, pad_token_id=generator.tokenizer.eos_token_id)print(output[0]["generated_text"])

The Gion neighborhood in Kyoto is famous for its many colorful green forests, such as the

Red Hill, the Red River and the Red River. The Gion neighborhood is home to the world's

tallest trees.

- Unklare Prompts können zu suboptimalen Ausgaben führen

Einflussnahme auf die Ausgabe

generator = pipeline(task="text-generation", model="distilgpt2")review = "This book was great. I enjoyed the plot twist in Chapter 10." response = "Dear reader, thank you for your review." prompt = f"Book review: {review} Book shop response to the review: {response}"output = generator(prompt, max_length=100, pad_token_id=generator.tokenizer.eos_token_id) print(output[0]["generated_text"])Dear reader, thank you for your review. We'd like to thank you for your reading!

Übersetzung in andere Sprachen

- Hugging Face hat eine umfassende Liste von Übersetzungsaufgaben und Modellen.

translator = pipeline(task="translation_en_to_es", model="Helsinki-NLP/opus-mt-en-es")text = "Walking amid Gion's Machiya wooden houses was a mesmerizing experience."output = translator(text, clean_up_tokenization_spaces=True)print(output[0]["translation_text"])

Caminar entre las casas de madera Machiya de Gion fue una experiencia fascinante.

Lass uns üben!

Einführung in LLMs mit Python