Einführung in PySpark

Einführung in PySpark

Benjamin Schmidt

Data Engineer

Lerne deinen Kursleiter kennen

- Fast ein Jahrzehnt Erfahrung mit Datenverarbeitung mit PySpark

PySpark angewendet für maschinelles Lernen, ETL-Aufgaben und vieles mehr

Motivierter Lehrer für neue Tools für alle!

Was ist PySpark?

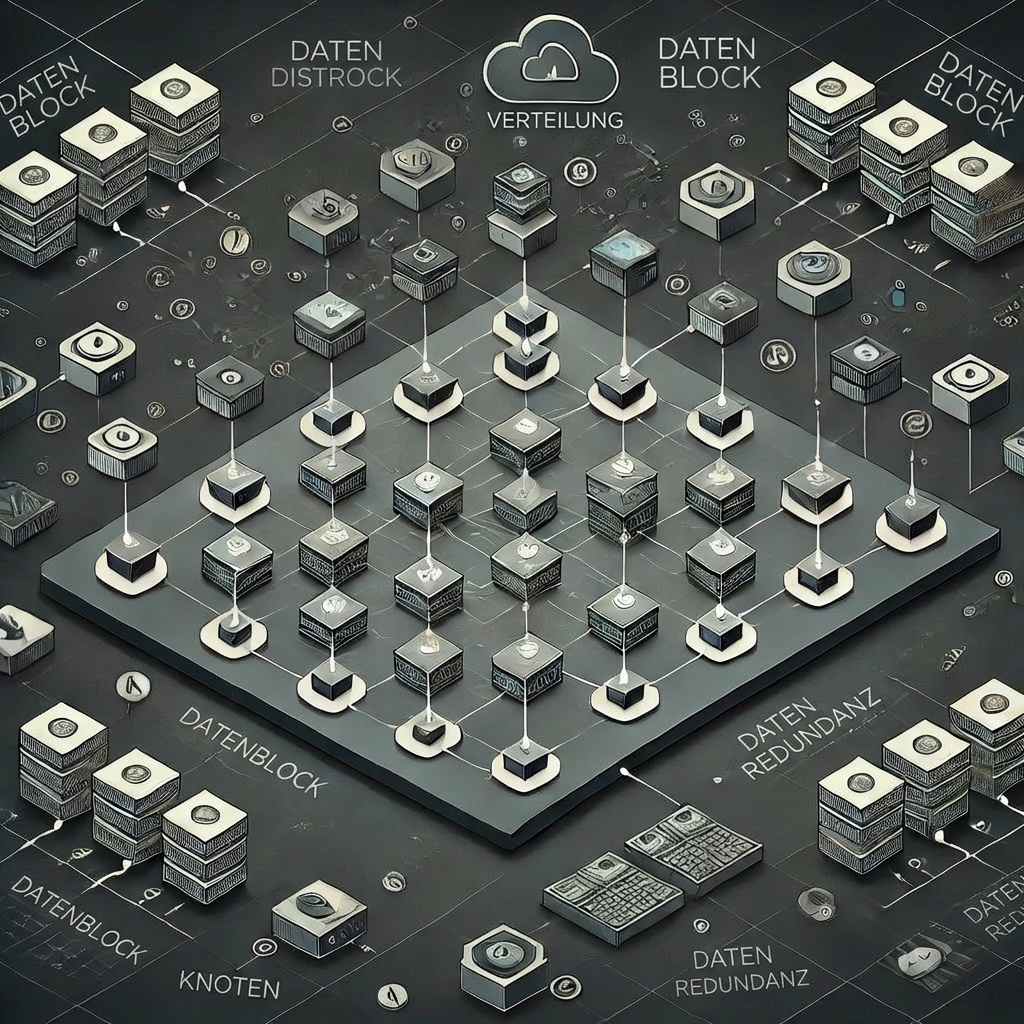

Verteilte Datenverarbeitung: Entwickelt, um große Datenmengen über Cluster hinweg zu verarbeiten

Unterstützt verschiedene Datenformate wie CSV, Parquet und JSON

Eine SQL-Integration ermöglicht Abfragen sowohl mit Python- als auch mit SQL-Syntax.

Optimiert für Geschwindigkeit bei großen Datenmengen und Operationen

Wann nutzen wir PySpark?

Big-Data-Analyse

Verteilte Datenverarbeitung

Echtzeit-Datenstreaming

Maschinelles Lernen mit großen Datensätzen

ETL- und ELT-Pipelines

Arbeit mit verschiedenen Datenquellen:

- CSV

- JSON

- Parquet

- Viele, viele mehr

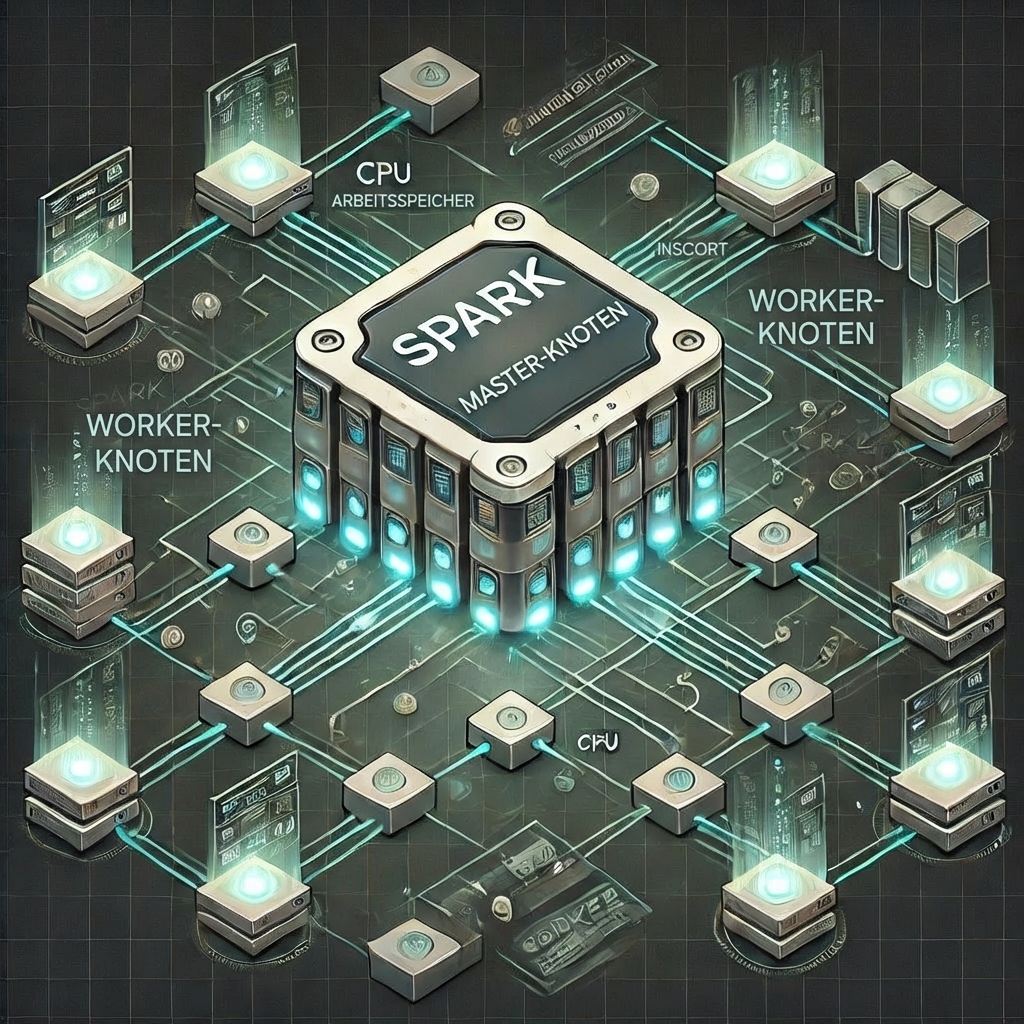

Spark-Cluster

Master-Node

- Verwaltet den Cluster, koordiniert Aufgaben und terminiert Jobs

Worker-Nodes

- Führen vom Master zugeteilte Aufgaben aus.

- Zuständig für die eigentlichen Berechnungen und das Speichern von Daten im Speicher oder auf der Festplatte

SparkSession

- Zugriff auf Spark-Cluster. Wichtig, wenn du PySpark nutzen willst.

# Import SparkSession

from pyspark.sql import SparkSession

# Initialize a SparkSession

spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

$$

.builder()eine Session einrichtetgetOrCreate()erstellt oder ruft eine Session ab.appName()hilft beim Verwalten mehrerer Sessions

PySpark-DataFrames

- Ähnlich wie andere DataFrames

- Aber: Optimiert für PySpark

# Import and initialize a Spark session

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

# Create a DataFrame

census_df = spark.read.csv("census.csv",

["gender","age","zipcode","salary_range_usd","marriage_status"])

# Show the DataFrame

census_df.show()

Lass uns üben!

Einführung in PySpark