Introduction à PySpark

Introduction à PySpark

Benjamin Schmidt

Data Engineer

Rencontrez votre instructeur

- Près de dix ans d'expérience en données avec PySpark

Utilisé pour le Machine Learning, les tâches ETL, et bien plus

Enseignant enthousiaste des nouveaux outils pour tous !

-

Qu'est-ce que PySpark ?

Traitement distribué des données : Conçu pour gérer de grands ensembles de données sur des clusters

Prend en charge divers formats de données, y compris CSV, Parquet et JSON

Intégration SQL permettant de requêter les données en Python et SQL

Optimisé pour la vitesse à grande échelle

Quand utiliser PySpark ?

Analyse de big data

Traitement distribué des données

Streaming de données en temps réel

Machine learning sur de grands ensembles de données

Pipelines ETL et ELT

Travail avec diverses sources de données :

- CSV

- JSON

- Parquet

- Bien d'autres encore

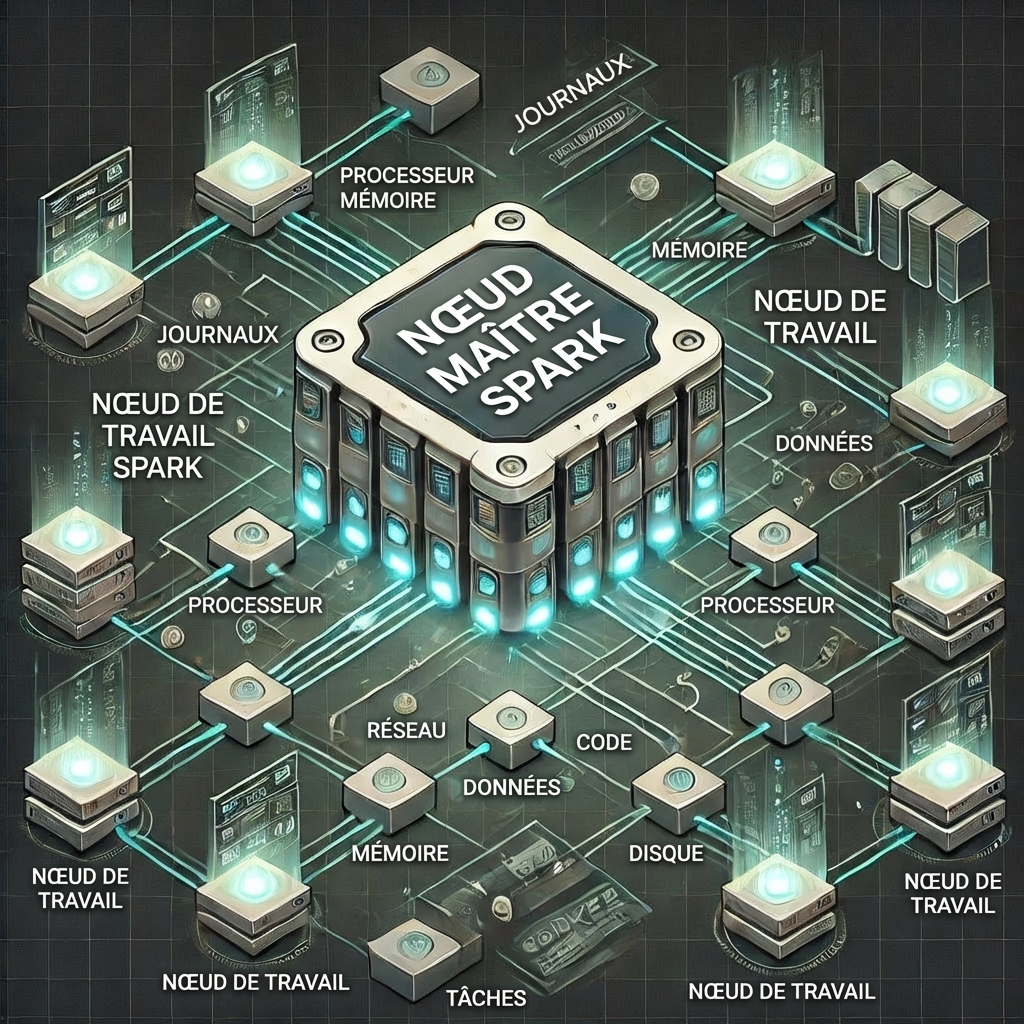

Cluster Spark

Nœud maître

- Gère le cluster, coordonne les tâches et planifie les travaux

Nœuds de travail

- Exécutent les tâches assignées par le maître

- Responsables de l'exécution des calculs et du stockage des données en mémoire ou sur disque

SparkSession

- Les SparkSessions vous permettent d'accéder à votre cluster Spark et sont essentielles pour utiliser PySpark.

# Importer SparkSession

from pyspark.sql import SparkSession

# Initialiser une SparkSession

spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

$$

.builder()configure une sessiongetOrCreate()crée ou récupère une session.appName()aide à gérer plusieurs sessions

DataFrames PySpark

- Similaire à d'autres DataFrames mais

- Optimisé pour PySpark

# Importer et initialiser une session Spark

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

# Créer un DataFrame

census_df = spark.read.csv("census.csv",

["gender","age","zipcode","salary_range_usd","marriage_status"])

# Afficher le DataFrame

census_df.show()

Passons à la pratique !

Introduction à PySpark