Introdução ao PySpark

Introdução ao PySpark

Benjamin Schmidt

Data Engineer

Conheça seu instrutor

- Quase uma década de experiência com PySpark

Usou PySpark para Machine Learning, ETL e muito mais

Professor entusiasta de novas ferramentas para todos!

-

O que é PySpark?

Processamento distribuído: Projetado para grandes conjuntos de dados em clusters

Suporta vários formatos de dados, incluindo CSV, Parquet e JSON

Integração com SQL permite consultas usando Python e SQL

Otimizado para velocidade em escala

Quando usar PySpark?

Análise de big data

Processamento de dados distribuído

Streaming de dados em tempo real

Machine learning em grandes conjuntos de dados

Pipelines ETL e ELT

Trabalhando com diversas fontes de dados:

- CSV

- JSON

- Parquet

- Muitos outros

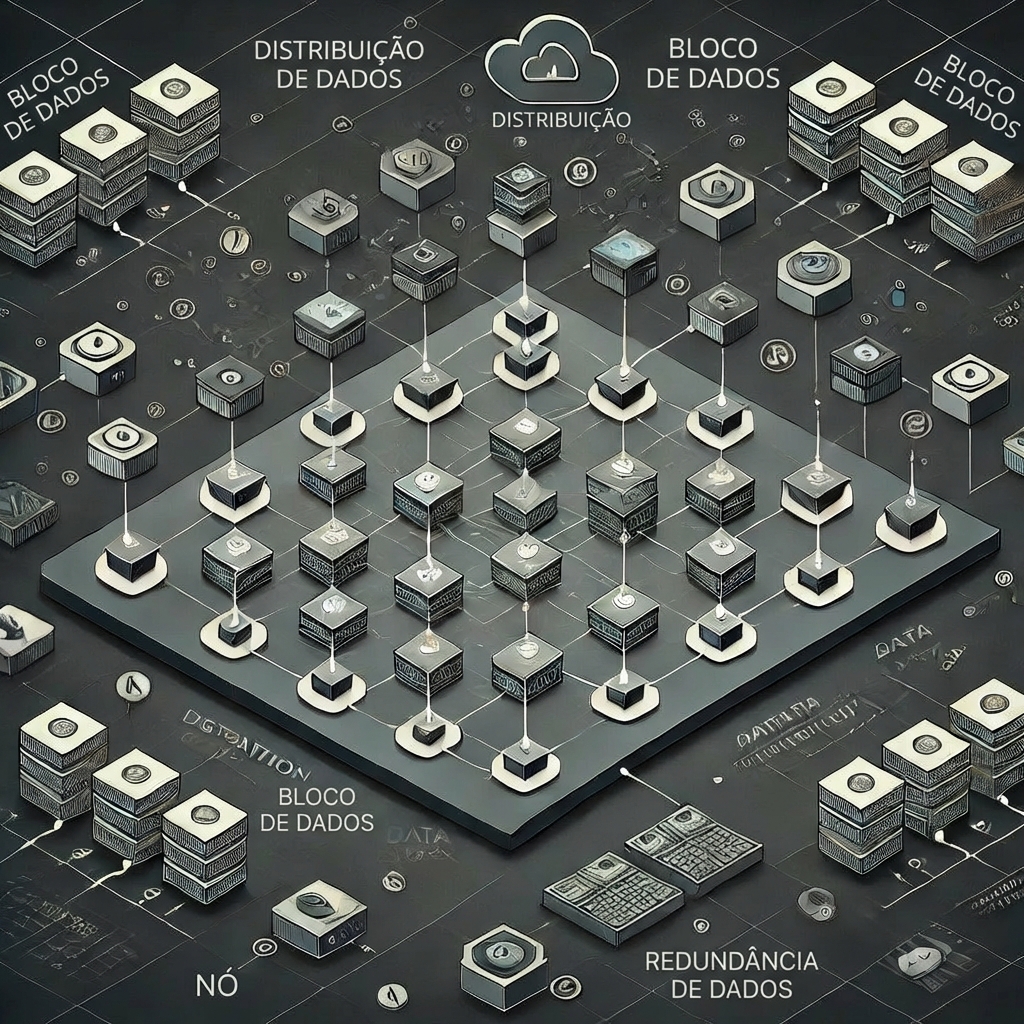

Cluster Spark

Nó Mestre

- Gerencia o cluster, coordena tarefas e agenda trabalhos

Nós Trabalhadores

- Executam as tarefas atribuídas pelo mestre

- Responsáveis por executar cálculos e armazenar dados em memória ou disco

SparkSession

- SparkSessions permitem acessar seu cluster Spark e são essenciais para usar PySpark.

# Importar SparkSession

from pyspark.sql import SparkSession

# Iniciar uma SparkSession

spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

$$

.builder()configura uma sessãogetOrCreate()cria ou recupera uma sessão.appName()ajuda a gerenciar várias sessões

DataFrames no PySpark

- Semelhante a outros DataFrames, mas

- Otimizado para PySpark

# Importar e iniciar uma sessão Spark

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

# Criar um DataFrame

census_df = spark.read.csv("census.csv",

["gender","age","zipcode","salary_range_usd","marriage_status"])

# Mostrar o DataFrame

census_df.show()

Vamos praticar!

Introdução ao PySpark