Introducción a PySpark

Introducción a PySpark

Benjamin Schmidt

Data Engineer

Conoce a tu instructor

- Casi una década de experiencia en datos con PySpark

Uso de PySpark para Machine Learning, tareas ETL y mucho más

¡Entusiasta profesor de nuevas herramientas para todos!

-

¿Qué es PySpark?

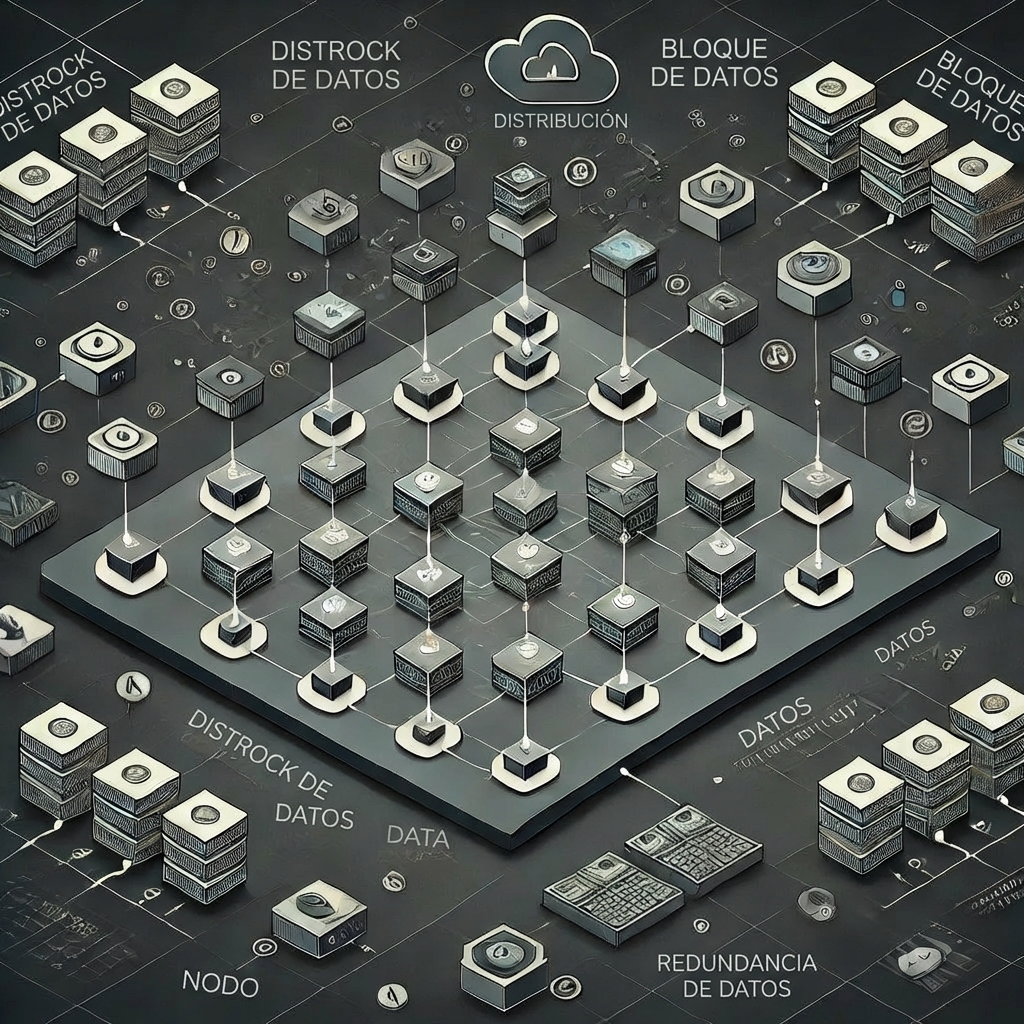

Procesamiento de datos distribuido: Diseñado para manejar grandes conjuntos de datos en clústeres

Soporta varios formatos de datos, incluyendo CSV, Parquet y JSON

Integración con SQL permite consultar datos usando sintaxis de Python y SQL

Optimizado para velocidad a gran escala

¿Cuándo usar PySpark?

Análisis de big data

Procesamiento de datos distribuido

Transmisión de datos en tiempo real

Aprendizaje automático en grandes conjuntos de datos

Pipelines ETL y ELT

Trabajar con diversas fuentes de datos:

- CSV

- JSON

- Parquet

- Muchos más

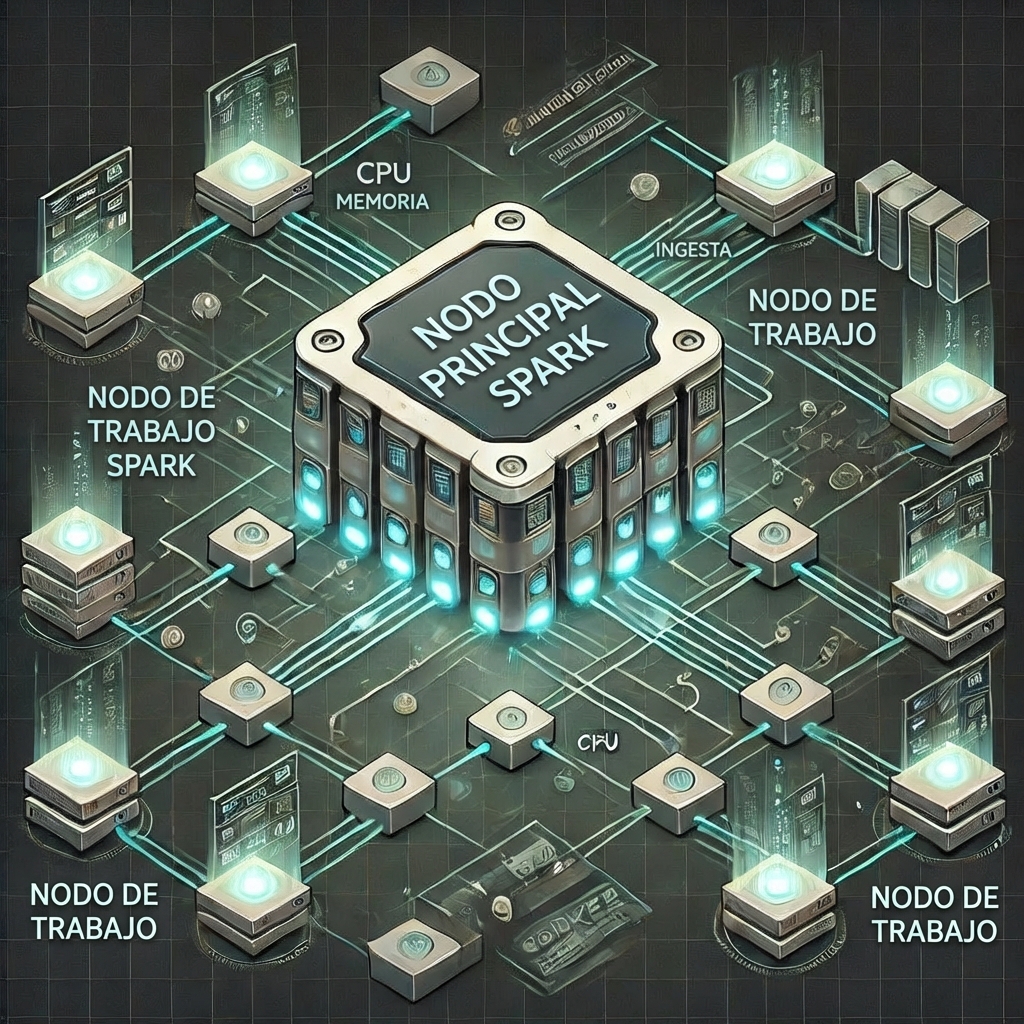

Clúster de Spark

Nodo Maestro

- Gestiona el clúster, coordina tareas y programa trabajos

Nodos Trabajadores

- Ejecutan las tareas asignadas por el maestro

- Responsables de ejecutar los cálculos y almacenar datos en memoria o disco

SparkSession

- SparkSessions te permiten acceder a tu clúster de Spark y son esenciales para usar PySpark.

# Importar SparkSession

from pyspark.sql import SparkSession

# Iniciar una SparkSession

spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

$$

.builder()configura una sesióngetOrCreate()crea o recupera una sesión.appName()ayuda a gestionar múltiples sesiones

DataFrames de PySpark

- Similar a otros DataFrames pero

- Optimizado para PySpark

# Importar e iniciar una sesión de Spark

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

# Crear un DataFrame

census_df = spark.read.csv("census.csv",

["gender","age","zipcode","salary_range_usd","marriage_status"])

# Mostrar el DataFrame

census_df.show()

¡Vamos a practicar!

Introducción a PySpark